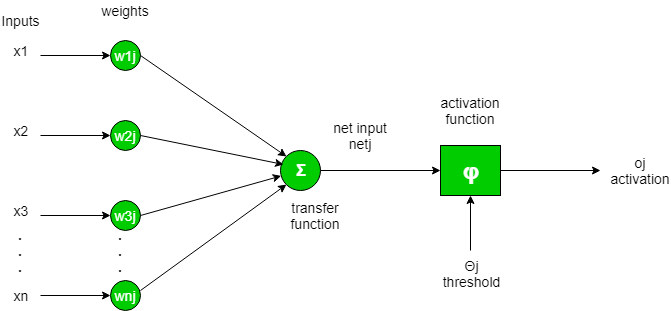

简单来说,人工神经元计算其输入的“加权和”并添加一个偏差,如下图所示的净输入。

在数学上,

![]()

现在净输入的值可以是从 -inf 到 +inf 的任何值。神经元并不真正知道如何绑定到值,因此无法决定发射模式。因此激活函数是人工神经网络的重要组成部分。他们基本上决定一个神经元是否应该被激活。因此它限制了净输入的值。

激活函数是一种非线性变换,在将输入发送到下一层神经元或将其作为输出最终确定之前,我们会对输入进行非线性变换。

激活函数的类型 –

深度学习中使用了几种不同类型的激活函数。其中一些解释如下:

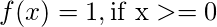

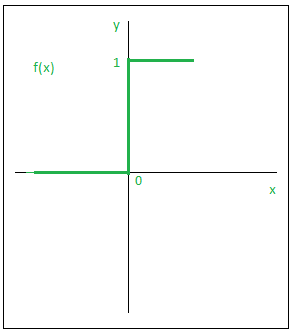

- 步骤函数:

Step 函数是最简单的激活函数之一。在这里,我们考虑一个阈值,如果净输入值表示y大于阈值,则神经元被激活。在数学上,

下面给出了阶跃函数的图形表示。

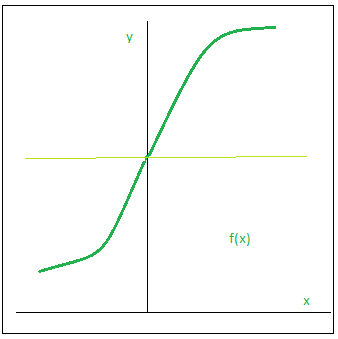

- 乙状函数:

Sigmoid函数是一种广泛使用的激活函数。它被定义为:

从图形上看,

这是一个平滑函数并且是连续可微的。它比阶跃和线性函数的最大优点是它是非线性的。这是 sigmoid函数的一个非常酷的特性。这本质上意味着,当我有多个具有 sigmoid函数作为激活函数的神经元时,输出也是非线性的。函数范围为 0-1,呈 S 形。

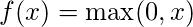

- ReLU:

ReLU函数是 Rectified 线性单元。它是使用最广泛的激活函数。它被定义为:

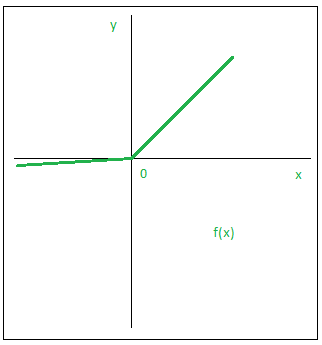

从图形上看,

与其他激活函数相比,使用 ReLU函数的主要优点是它不会同时激活所有神经元。这是什么意思 ?如果您查看 ReLU函数,如果输入为负,它会将其转换为零,并且神经元不会被激活。

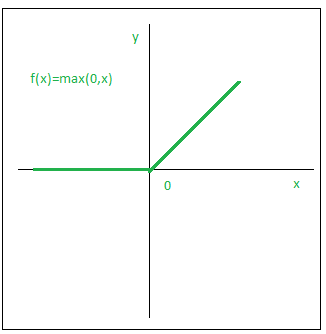

- 泄漏 ReLU:

漏泄RELU函数只不过是RELU函数的。相反的改进版本定义RELU函数0对于x小于0,我们将其定义为x的小的线性分量。它可以定义为:

从图形上看,