精确召回曲线|机器学习

有多种方法可以评估分类器的性能。在本文中,我们介绍了 Precision-Recall 曲线,并进一步研究了两种流行的性能报告方法之间的区别:Precision-Recall (PR) 曲线和接收器操作特性 (ROC) 曲线。

ROC 曲线已经在文章中讨论过了。让我们简单了解一下什么是 Precision-Recall 曲线。

精确召回 (PR) 曲线 –

PR 曲线只是一个图形,y 轴上有 Precision 值,x 轴上有 Recall 值。换句话说,PR 曲线在 y 轴上包含 TP/(TP+FN),在 x 轴上包含 TP/(TP+FP)。

- 需要注意的是,精度也称为正预测值 (PPV)。

- 召回率也称为灵敏度、命中率或真阳性率 (TPR)。

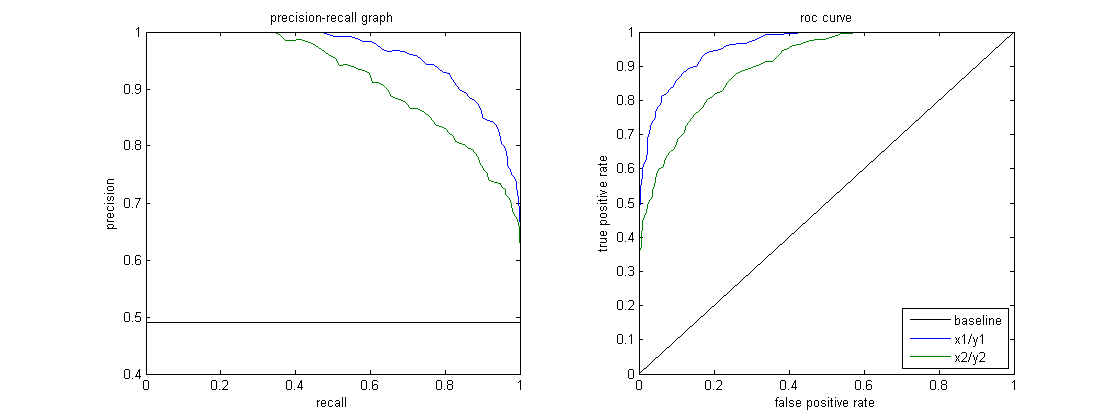

下图显示了样本 PR 和 ROC 曲线的并列。

解释公关曲线——

希望该算法既具有高精度,又具有高召回率。然而,大多数机器学习算法通常涉及两者之间的权衡。好的 PR 曲线具有更大的 AUC(曲线下面积)。上图中,蓝线对应的分类器比绿线对应的分类器性能更好。

需要注意的是,在 ROC 曲线上具有较高 AUC 的分类器在 PR 曲线上也总是具有较高的 AUC。

考虑一种对文档是否属于“体育”新闻类别进行分类的算法。假设有 12 个文档,具有以下基本事实(实际)和分类器输出类标签。

| Document ID | Ground Truth | Classifier Output |

|---|---|---|

| D1 | Sports | Sports |

| D2 | Sports | Sports |

| D3 | Not Sports | Sports |

| D4 | Sports | Not Sports |

| D5 | Not Sports | Not Sports |

| D6 | Sports | Not Sports |

| D7 | Not Sports | Sports |

| D8 | Not Sports | Not Sports |

| D9 | Not Sports | Not Sports |

| D10 | Sports | Sports |

| D11 | Sports | Sports |

| D12 | Sports | Not Sports |

现在,让我们找出 TP、TN、FP 和 FN 值。

TP = The document was classified as “Sports” and was actually “Sports”. D1, D2, D10, and D11 correspond to TP.

TN = The document was classified as “Not sports” and was actually “Not sports”. D5, D8, and D9 correspond to TN.

FP = The document was classified as “Sports” but was actually “Not sports”. D3 and D7 correspond to FP.

FN = The document was classified as “Not sports” but was actually “Sports”. D4, D6, and D12 correspond to FN.

So, TP = 4, TN = 3, FP = 2 and FN = 3.

Finally, precision = TP/(TP+FN) = 4/7 and recall = TP/(TP+FP) = 4/6 = 2/3. This means when the precision is 4/7, the recall is 2/3.

通过设置不同的阈值,我们得到多个这样的精度、召回率对。通过绘制多个这样的 PR 对,其中任一值的范围从 0 到 1,我们得到了一条 PR 曲线。

当ROC曲线存在时需要PR曲线吗?

PR 曲线在报告信息检索结果时特别有用。

信息检索涉及搜索文档池以查找与特定用户查询相关的文档。例如,假设用户输入搜索查询“粉红大象”。搜索引擎浏览数以百万计的文档(使用一些优化算法)以检索少量相关文档。因此,我们可以放心地假设没有。与否相比,相关文件的数量将非常少。不相关的文件。

在这种情况下,

TP = 实际相关的检索文档数(良好的结果)。

FP = 检索到的实际上不相关的文档(虚假搜索结果)的数量。

TN = 实际上不相关的未检索文档的数量。

FN = 实际相关的未检索文档的数量(我们错过的好文档)。

ROC 曲线是包含 x 轴上的 Recall = TPR = TP/(TP+FN) 和 y 轴上的 FPR = FP/(FP+TN) 的图。由于没有。真阴性(即实际上不相关的未检索文档)数量如此之大,FPR 变得微不足道。此外,FPR 并不能真正帮助我们很好地评估检索系统,因为我们希望更多地关注检索到的文档,而不是未检索到的文档。

PR曲线有助于解决这个问题。 PR 曲线在 x 轴上具有召回值 (TPR),在 y 轴上具有精度 = TP/(TP+FP)。精度有助于突出检索结果的相关性,这在判断 IR 系统时更为重要。

因此,PR 曲线通常在涉及信息检索的问题中更为常见。

参考:

- https://www.biostat.wisc.edu/~page/rocpr.pdf

- https://en.wikipedia.org/wiki/Evaluation_measures_(information_retrieval)