- Apache Solr教程

- 讨论Apache Solr

- 讨论Apache Solr(1)

- Apache Solr-概述(1)

- Apache Solr-概述

- Apache Solr-索引数据

- Apache Solr-索引数据(1)

- Apache Solr-查询数据(1)

- Apache Solr-查询数据

- Apache Solr-更新数据

- Apache Solr-核心(1)

- Apache Solr-核心

- Apache Solr-术语

- Apache Solr-术语(1)

- Apache Solr-删除文档

- Apache Solr-删除文档(1)

- Apache Solr-体系结构(1)

- Apache Solr-体系结构

- Apache Solr-基本命令(1)

- Apache Solr-基本命令

- Apache Solr-在Windows环境中

- Apache Solr-在Windows环境中(1)

- Apache Solr-有用的资源

- Apache Solr-有用的资源(1)

- Apache Solr-检索数据(1)

- Apache Solr-检索数据

- 大数据和 Apache Hadoop 的区别

- 大数据和 Apache Hadoop 的区别

- 大数据和 Apache Hadoop 的区别(1)

📅 最后修改于: 2020-12-02 05:43:31 🧑 作者: Mango

Solr可以与Hadoop一起使用。由于Hadoop处理大量数据,Solr帮助我们从如此大量的资源中查找所需的信息。在本节中,让我们了解如何在系统上安装Hadoop。

下载Hadoop

下面给出了将Hadoop下载到系统上要遵循的步骤。

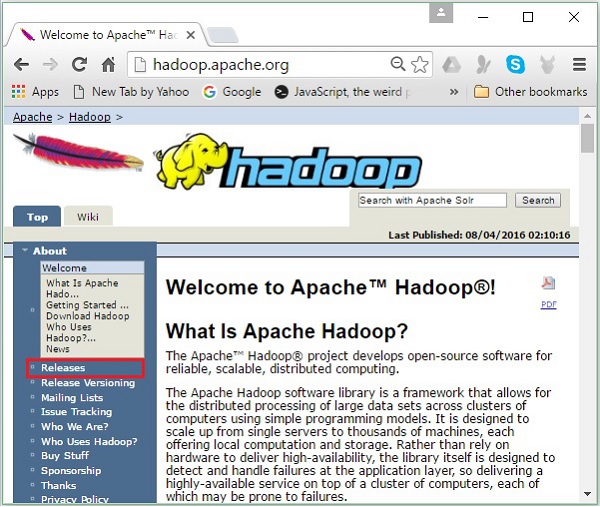

步骤1-转到Hadoop的主页。您可以使用链接-www.hadoop.apache.org/ 。单击链接Releases ,如以下屏幕快照中突出显示。

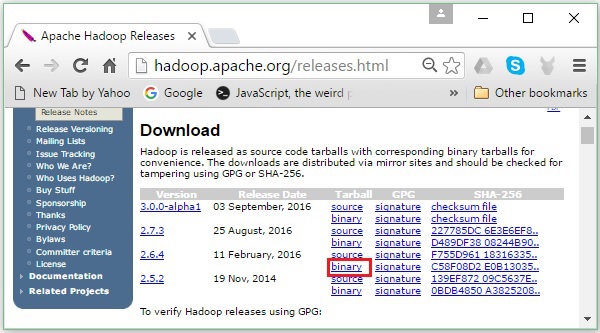

它将重定向到Apache Hadoop Releases页面,该页面包含各种版本Hadoop的源文件和二进制文件的镜像的链接,如下所示-

步骤2-选择最新版本的Hadoop(在我们的教程中为2.6.4),然后单击其二进制链接。它将带您到一个页面,其中有Hadoop二进制文件的镜像可用。单击这些镜像之一以下载Hadoop。

从命令提示符下载Hadoop

打开Linux终端并以超级用户身份登录。

$ su

password:

转到需要安装Hadoop的目录,然后使用先前复制的链接将文件保存在该目录中,如以下代码块所示。

# cd /usr/local

# wget http://redrockdigimark.com/apachemirror/hadoop/common/hadoop-

2.6.4/hadoop-2.6.4.tar.gz

下载Hadoop之后,使用以下命令将其解压缩。

# tar zxvf hadoop-2.6.4.tar.gz

# mkdir hadoop

# mv hadoop-2.6.4/* to hadoop/

# exit

安装Hadoop

请按照下面给出的步骤以伪分布式模式安装Hadoop 。

步骤1:设定Hadoop

您可以通过将以下命令附加到〜/ .bashrc文件来设置Hadoop环境变量。

export HADOOP_HOME = /usr/local/hadoop export

HADOOP_MAPRED_HOME = $HADOOP_HOME export

HADOOP_COMMON_HOME = $HADOOP_HOME export

HADOOP_HDFS_HOME = $HADOOP_HOME export

YARN_HOME = $HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR = $HADOOP_HOME/lib/native

export PATH = $PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

export HADOOP_INSTALL = $HADOOP_HOME

接下来,将所有更改应用于当前正在运行的系统。

$ source ~/.bashrc

步骤2:Hadoop配置

您可以在“ $ HADOOP_HOME / etc / hadoop”位置找到所有Hadoop配置文件。需要根据您的Hadoop基础架构在这些配置文件中进行更改。

$ cd $HADOOP_HOME/etc/hadoop

为了用Java开发Hadoop程序,您必须通过用系统中Java的位置替换JAVA_HOME值来重置hadoop-env.sh文件中的Java环境变量。

export JAVA_HOME = /usr/local/jdk1.7.0_71

以下是您必须编辑以配置Hadoop的文件列表-

- core-site.xml

- hdfs-site.xml

- yarn-site.xml

- mapred-site.xml

core-site.xml

core-site.xml文件包含以下信息,例如用于Hadoop实例的端口号,为文件系统分配的内存,用于存储数据的内存限制以及读/写缓冲区的大小。

打开core-site.xml,并在

fs.default.name

hdfs://localhost:9000

hdfs-site.xml

hdfs-site.xml文件包含诸如本地文件系统的复制数据的值,名称节点路径和数据节点路径之类的信息。这意味着您要存储Hadoop基础架构的位置。

让我们假设以下数据。

dfs.replication (data replication value) = 1

(In the below given path /hadoop/ is the user name.

hadoopinfra/hdfs/namenode is the directory created by hdfs file system.)

namenode path = //home/hadoop/hadoopinfra/hdfs/namenode

(hadoopinfra/hdfs/datanode is the directory created by hdfs file system.)

datanode path = //home/hadoop/hadoopinfra/hdfs/datanode

打开此文件,并在

dfs.replication

1

dfs.name.dir

file:///home/hadoop/hadoopinfra/hdfs/namenode

dfs.data.dir

file:///home/hadoop/hadoopinfra/hdfs/datanode

注–在上面的文件中,所有属性值都是用户定义的,您可以根据Hadoop基础结构进行更改。

yarn-site.xml

该文件用于将yarn配置到Hadoop中。打开yarn-site.xml文件,并在此文件的

yarn.nodemanager.aux-services

mapreduce_shuffle

mapred-site.xml

该文件用于指定我们使用的MapReduce框架。默认情况下,Hadoop包含一个yarn-site.xml模板。首先,需要使用以下命令将文件从mapred-site,xml.template复制到mapred-site.xml文件。

$ cp mapred-site.xml.template mapred-site.xml

打开mapred-site.xml文件,并在

mapreduce.framework.name

yarn

验证Hadoop安装

以下步骤用于验证Hadoop安装。

步骤1:名称节点设置

如下所示,使用命令“ hdfs namenode –format”设置名称节点。

$ cd ~

$ hdfs namenode -format

预期结果如下。

10/24/14 21:30:55 INFO namenode.NameNode: STARTUP_MSG:

/************************************************************

STARTUP_MSG: Starting NameNode

STARTUP_MSG: host = localhost/192.168.1.11

STARTUP_MSG: args = [-format] STARTUP_MSG: version = 2.6.4

...

...

10/24/14 21:30:56 INFO common.Storage: Storage directory

/home/hadoop/hadoopinfra/hdfs/namenode has been successfully formatted.

10/24/14 21:30:56 INFO namenode.NNStorageRetentionManager: Going to retain 1

images with txid >= 0

10/24/14 21:30:56 INFO util.ExitUtil: Exiting with status 0

10/24/14 21:30:56 INFO namenode.NameNode: SHUTDOWN_MSG:

/************************************************************

SHUTDOWN_MSG: Shutting down NameNode at localhost/192.168.1.11

************************************************************/

步骤2:验证Hadoop DFS

以下命令用于启动Hadoop dfs。执行此命令将启动Hadoop文件系统。

$ start-dfs.sh

预期的输出如下-

10/24/14 21:37:56

Starting namenodes on [localhost]

localhost: starting namenode, logging to /home/hadoop/hadoop-2.6.4/logs/hadoop-

hadoop-namenode-localhost.out

localhost: starting datanode, logging to /home/hadoop/hadoop-2.6.4/logs/hadoop-

hadoop-datanode-localhost.out

Starting secondary namenodes [0.0.0.0]

步骤3:验证纱线脚本

以下命令用于启动Yarn脚本。执行此命令将启动Yarn恶魔。

$ start-yarn.sh

预期输出如下-

starting yarn daemons

starting resourcemanager, logging to /home/hadoop/hadoop-2.6.4/logs/yarn-

hadoop-resourcemanager-localhost.out

localhost: starting nodemanager, logging to /home/hadoop/hadoop-

2.6.4/logs/yarn-hadoop-nodemanager-localhost.out

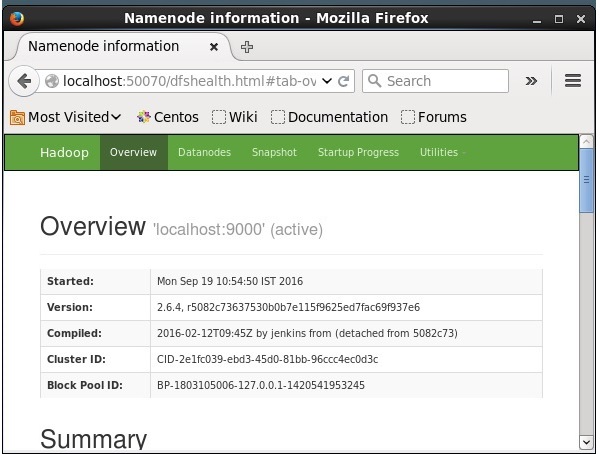

步骤4:在浏览器上访问Hadoop

访问Hadoop的默认端口号是50070。使用以下URL在浏览器上获取Hadoop服务。

http:// localhost:50070 /

在Hadoop上安装Solr

请按照以下步骤下载并安装Solr。

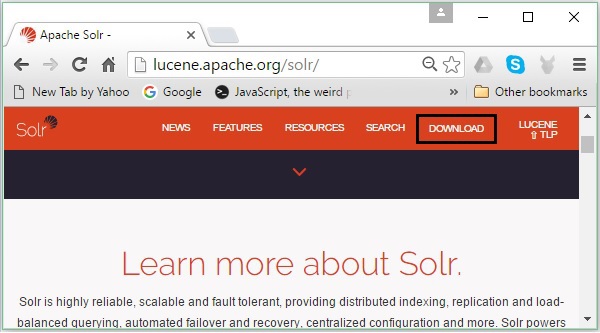

第1步

通过单击以下链接打开Apache Solr的主页-https: //lucene.apache.org/solr/

第2步

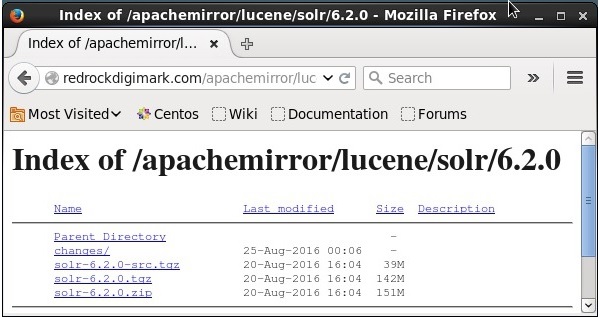

单击下载按钮(在上面的屏幕快照中突出显示)。单击后,您将被重定向到具有Apache Solr的各种镜像的页面。选择一个镜像并单击它,这会将您重定向到一个页面,您可以在其中下载Apache Solr的源文件和二进制文件,如以下屏幕快照所示。

第三步

单击后,将在系统的下载文件夹中下载一个名为Solr-6.2.0.tqz的文件夹。提取下载文件夹的内容。

第4步

在Hadoop主目录中创建一个名为Solr的文件夹,并将提取的文件夹的内容移至该文件夹,如下所示。

$ mkdir Solr

$ cd Downloads

$ mv Solr-6.2.0 /home/Hadoop/

验证

浏览Solr Home目录的bin文件夹,并使用version选项验证安装,如以下代码块所示。

$ cd bin/

$ ./Solr version

6.2.0

设置家和路径

使用以下命令打开.bashrc文件-

[Hadoop@localhost ~]$ source ~/.bashrc

现在为Apache Solr设置主目录和路径目录,如下所示:

export SOLR_HOME = /home/Hadoop/Solr

export PATH = $PATH:/$SOLR_HOME/bin/

打开终端并执行以下命令-

[Hadoop@localhost Solr]$ source ~/.bashrc

现在,您可以从任何目录执行Solr的命令。