📌 相关文章

- Microsoft Azure – Azure 数据工厂简介

- Microsoft Azure – Azure 数据工厂简介(1)

- 工厂函数 (1)

- 添加工厂数据 laravel - PHP (1)

- 添加工厂数据 laravel - PHP 代码示例

- laravel 工厂 (1)

- javascript中的工厂函数(1)

- javascript代码示例中的工厂函数

- 工厂函数 - 任何代码示例

- azure (1)

- laravel 工厂 - 任何代码示例

- JavaScript 中的工厂函数是什么?(1)

- JavaScript 中的工厂函数是什么?

- 工厂设计模式 (1)

- AngularJS |工厂方法

- AngularJS |工厂方法(1)

- 无法选择状态类型字符串数据工厂 (1)

- Java 9-集合工厂方法

- Java 9-集合工厂方法(1)

- Scala 中的工厂模式

- Scala 中的工厂模式(1)

- testng 中的工厂 (1)

- selenium 中的页面工厂类 (1)

- 无法选择状态类型字符串数据工厂 - 无论代码示例

- Microsoft Azure – 使用 Azure CLI 配置 Azure SQL(1)

- Microsoft Azure – 使用 Azure CLI 配置 Azure SQL

- 工厂设计模式 - 任何代码示例

- 工厂方法Python设计模式(1)

- Python中的工厂方法设计模式(1)

📜 Azure数据工厂

📅 最后修改于: 2021-01-07 05:00:14 🧑 作者: Mango

Azure数据工厂

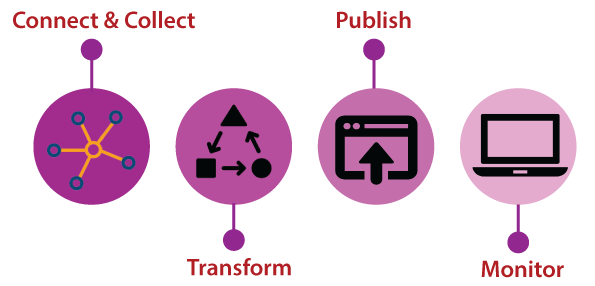

Azure数据工厂是基于云的数据集成服务,使我们能够在云中创建数据驱动的工作流,以编排和自动执行数据移动和数据转换。 Data Factory是Cloud上的完美ETL工具。 Data Factory旨在在云内交付提取,转换和加载过程。 ETL过程通常包括四个步骤:

- 连接和收集:我们可以在数据管道中使用复制活动来移动本地和云源数据存储中的数据。

- 转换:一旦数据出现在云中的集中式数据存储中,就可以使用HDInsight Hadoop,Spark,Data Lake Analytics和Machine Learning等计算服务来处理或转换收集的数据。

- 发布:将原始数据精简为可用于业务的消耗形式之后,它将数据加载到Azure数据仓库,Azure SQL数据库和Azure Cosmos DB等中。

- 监视器: Azure Data Factory内置了对通过Azure门户上的Azure Monitor,API,PowerShell,Log Analytics和运行状况面板进行管道监视的支持。

数据工厂的组成

数据工厂由四个关键元素组成。所有这些组件协同工作,以提供一个平台,您可以在该平台上形成具有数据移动和转换数据结构的数据驱动的工作流。

- 管道:数据工厂可以具有一个或多个管道。这是执行一个工作单元的活动的逻辑分组。管道中的活动完全执行任务。例如,管道可以包含一组活动,这些活动从Azure blob提取数据,然后在HDInsight群集上运行Hive查询以对数据进行分区。

- 活动:它代表管道中的处理步骤。例如-我们可能使用复制活动将数据从一个数据存储复制到另一数据存储。

- 数据集:它表示数据存储中的数据结构,这些数据结构指向或引用我们要在活动中用作I / O的数据。

- 链接的服务:就像连接字符串,它定义了Data Factory连接到外部资源所需的连接信息。链接服务可以是数据存储和计算资源。链接服务可以是到数据存储的链接,也可以是计算机资源。

- 触发器:它表示确定何时需要禁用管道执行的处理单位。我们还可以安排这些活动在某个时间点执行,并且可以使用触发器来禁用活动。

- 控制流:这是管道活动的编排,包括按顺序链接活动,分支,在管道级别定义参数以及在按需或从触发器调用管道时传递参数。我们可以使用控制流对某些活动进行排序,还可以为每个活动定义需要传递哪些参数。

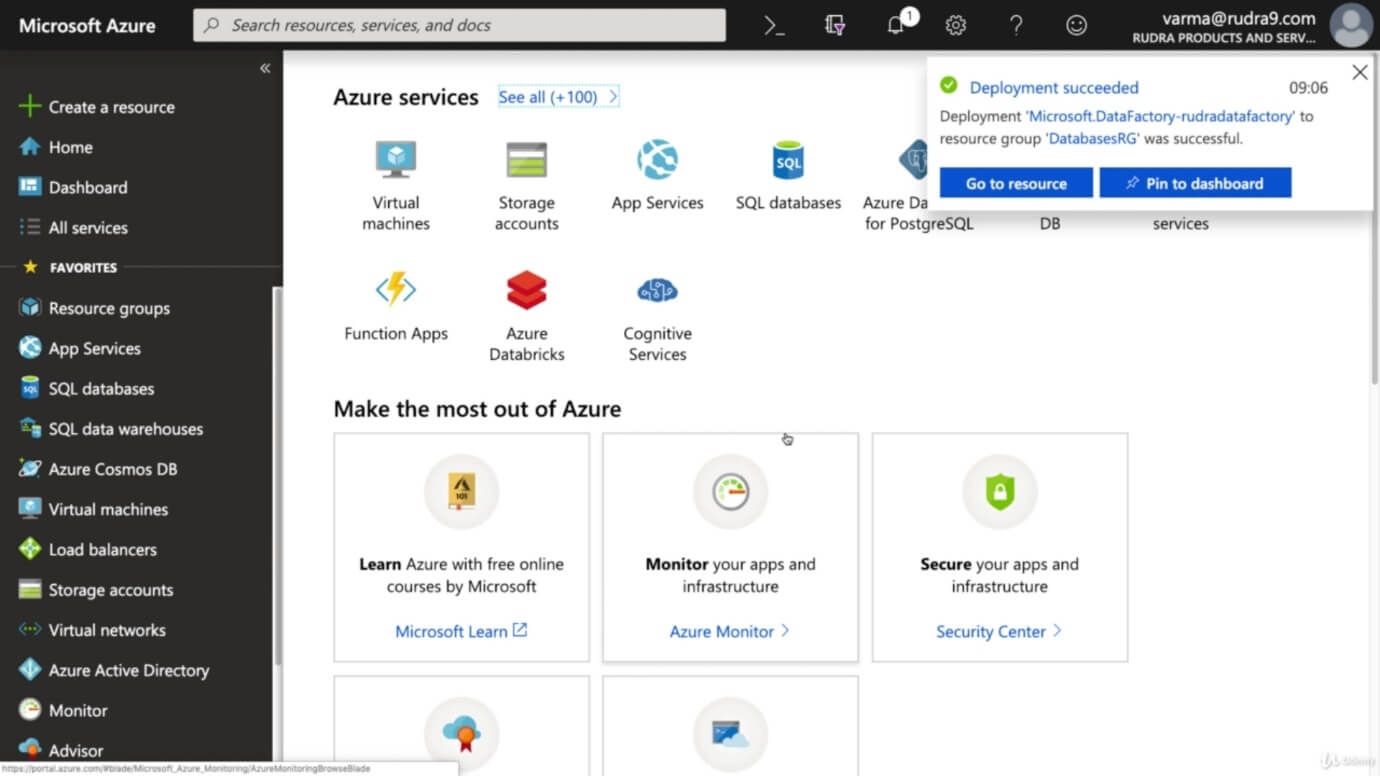

使用Azure门户创建Azure Data-Factory

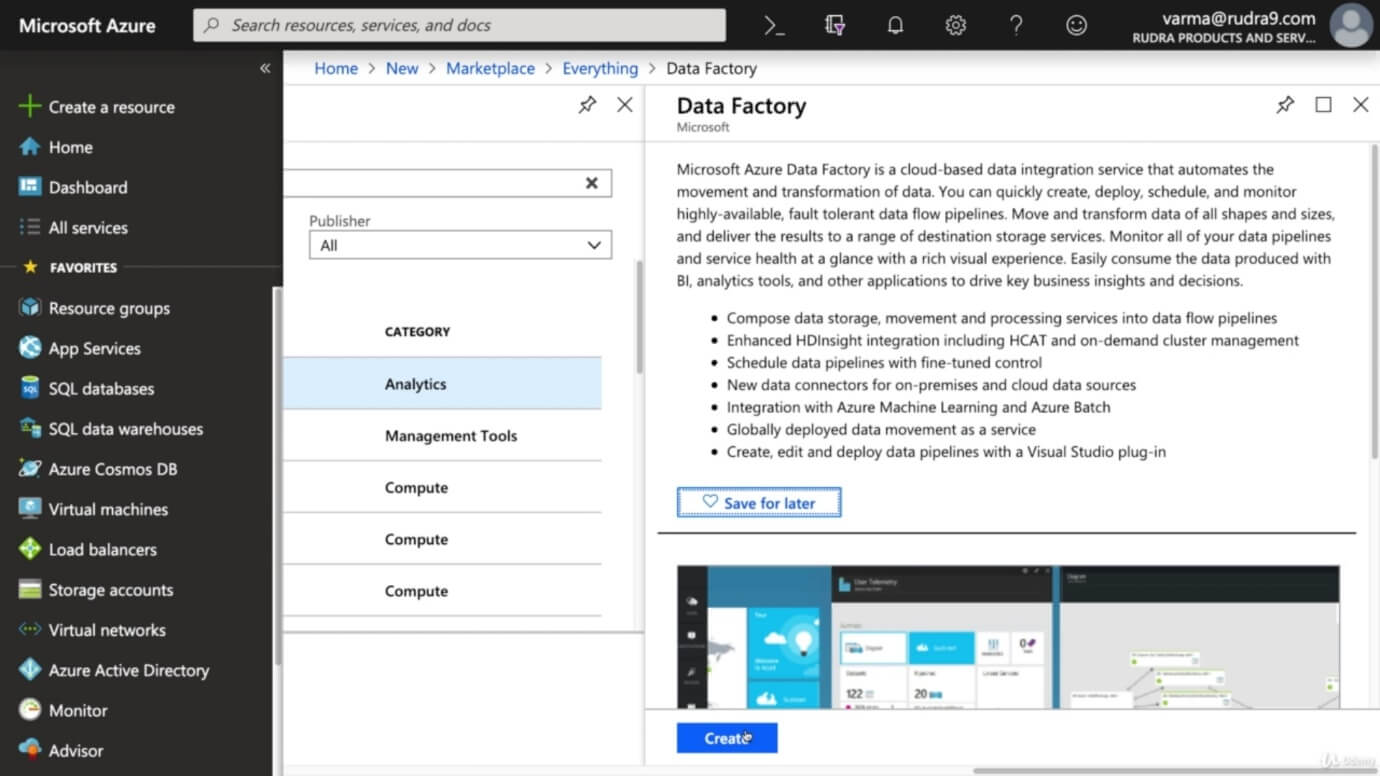

步骤1:点击创建资源并搜索数据工厂,然后点击创建。

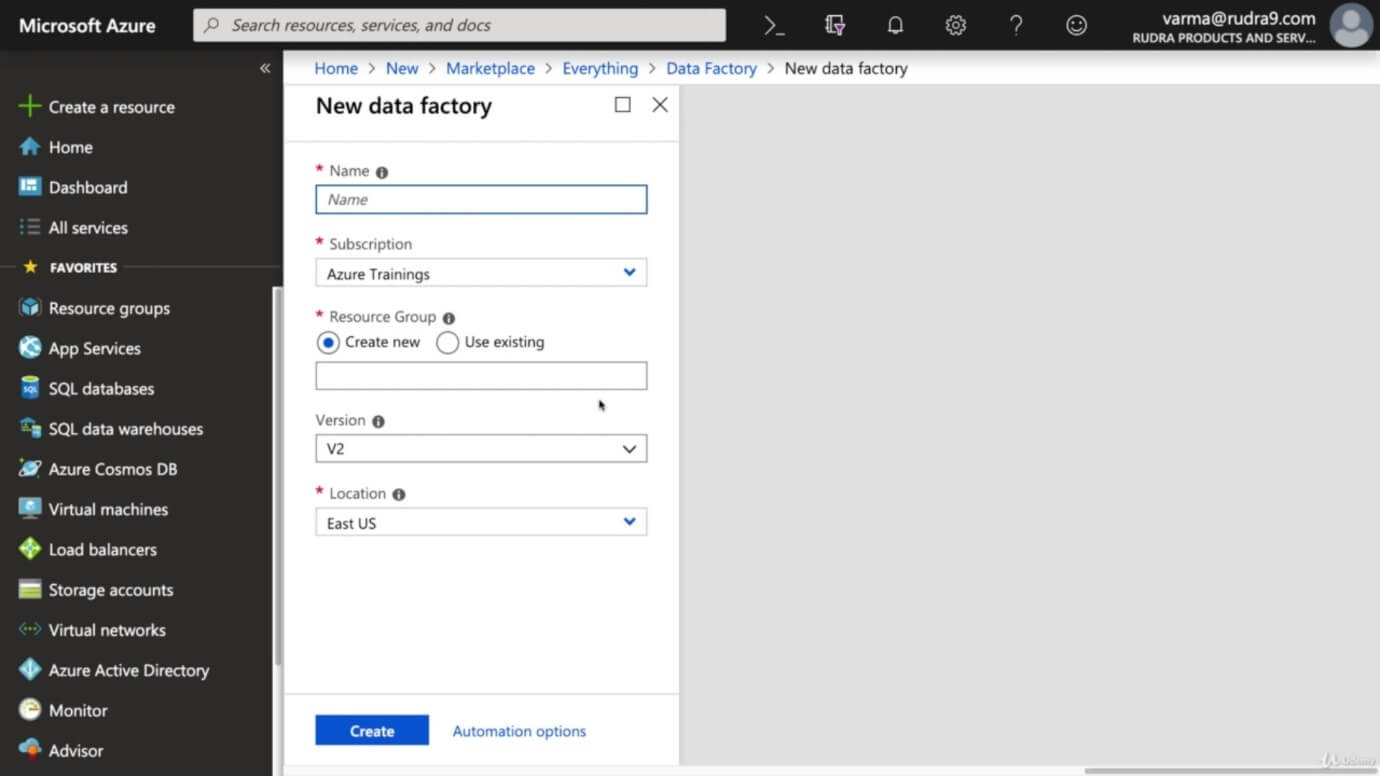

步骤2:为数据工厂提供名称,选择资源组,然后选择要部署数据工厂的位置和版本。

步骤3:填写所有详细信息后,单击“创建”。

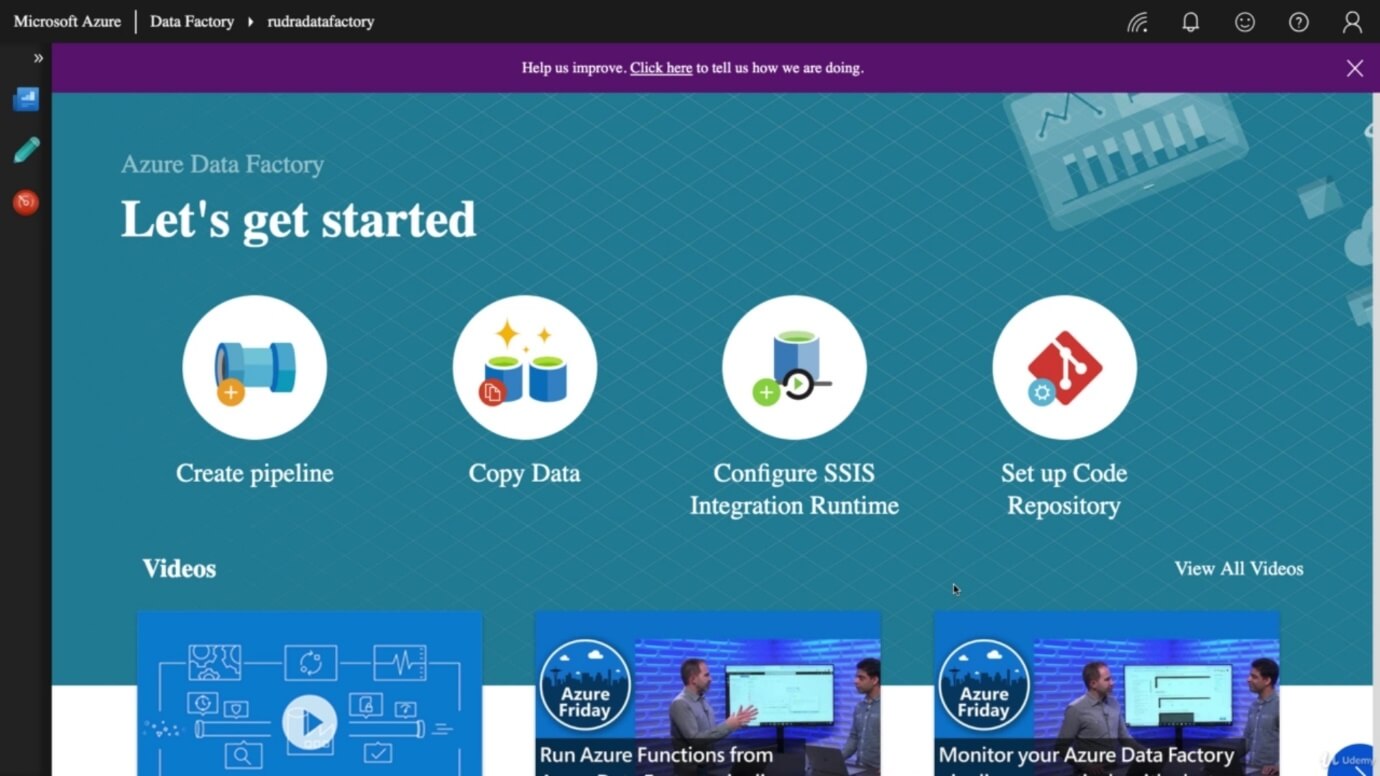

Azure数据工厂完全具有另一个门户,如下图所示。