前提条件机器学习

任何数据分析的目的都是从原始信息中提取准确的估算值。关于响应变量(Y)与解释变量(Xi)之间是否存在统计关系的最重要,最常见的问题之一。回答此问题的一种选择是采用回归分析来建立其关系模型。此外,它可以用于预测任意解释变量集的响应变量。

问题:

多元回归是最简单的机器学习算法之一。它属于监督学习算法的类别,即,当我们提供训练数据集时。使用此模型可以解决的一些问题是:

- 研究人员收集了有关三个心理变量,四个学术变量(标准化考试成绩)以及该学生针对600名高中生所接受的教育课程类型的数据。她对心理变量集与学业变量以及学生所学课程的类型之间的关系很感兴趣。

- 医生收集了有关胆固醇,血压和体重的数据。她还收集了有关受试者饮食习惯的数据(例如,每周消耗多少盎司的红肉,鱼,乳制品和巧克力)。她想研究健康的三项指标与饮食习惯之间的关系。

- 房地产经纪人希望根据各种因素(例如房屋大小,卧室数量,房屋年龄等)来设置房价。我们将使用此示例进一步讨论该算法。

解决方案:

解决方案分为多个部分。

- 选择特征:查找(或不依赖)响应变量所依赖的特征是“多元回归”中最重要的步骤之一。为了简化分析,我们假设已经选择了响应变量所依赖的功能。

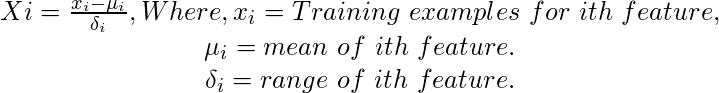

- 对特征进行归一化:然后对特征进行缩放,以使它们处于(0,1)的范围内,以进行更好的分析。可以通过以下方法更改每个功能的值来完成此操作:

- 选择假设和成本函数:假设是由h(x)表示的响应变量的预测值。成本函数定义了错误预测假设的成本。它应该尽可能小。我们选择假设函数作为特征X的线性组合。

![由QuickLaTeX.com渲染 \begin{matrix} h(x^i)=\theta _0 +\theta _1x_1^i+........+\theta _nx_n^i \\ where\Theta =[\theta _0 +\theta _1+........+\theta _n]^Tis\ the \ parameter\ vector, \\ and \ x_i^j=value\ of \ ith\ feature\ in \ jth\ training\ example. \\ And\ the\ cost\ function\ as \ sum\ of\ squared\ error\ over\ all\ training\ examples.\\ J(\theta )=\frac {1}{2m*\sum (h_\theta(x^i)-y^i)^2}\end{matrix}](https://mangdo-1254073825.cos.ap-chengdu.myqcloud.com//front_eng_imgs/geeksforgeeks2021/Multivariate%20Regression_1.jpg)

- 最小化成本函数:接下来,一些最小化成本算法在数据集上运行,从而调整假设的参数。一旦针对训练数据集最小化了成本函数,并且如果该关系是通用的,那么对于任意数据集也应将其最小化。在多元回归的情况下,梯度下降算法是使成本函数最小化的不错选择。

- 测试假设:然后在测试集上测试假设函数,以检查其正确性和效率。

实施方式:

借助矩阵运算,可以有效地实施多元回归技术。使用Python,可以使用“ numpy”库来实现,该库包含矩阵对象的定义和操作。

该代码需要用于Python的“ numpy”库(www.numpy.org/),该库尚未安装在GfG服务器上,因此该代码无法在gfg IDE上运行。但是,到代码的链接是:

代码:https://ide.geeksforgeeks.org/WxxMIg

参考:

[1] http://cs229.stanford.edu(有关多元回归的更多信息)

[2] http://docs.scipy.org(用于将“ numpy”库与Python)

[3]一些例子摘自

http://www.ats.ucla.edu/stat/stata/dae/mvreg.htm