📌 相关文章

- 机器学习中的正则化(1)

- 机器学习中的 P 值

- C++中的机器学习(1)

- 机器学习中的 P 值(1)

- C++中的机器学习

- 机器学习 (1)

- 机器学习 python (1)

- 机器学习 python 代码示例

- 机器学习 - 任何代码示例

- 什么是机器学习?

- 什么是机器学习?(1)

- 机器学习-什么是P值

- 在机器学习中什么是“i” (1)

- 机器学习-什么是P值(1)

- 学习 python 机器学习 - 任何代码示例

- 机器学习-什么是机器学习? -指导点(1)

- 机器学习-什么是机器学习? -指导点

- 机器学习算法(1)

- 机器学习算法

- 使用Python机器学习-方法

- 使用Python机器学习-方法(1)

- 如何开始学习机器学习?

- 如何开始学习机器学习?(1)

- 自动机器学习

- 自动机器学习(1)

- 具有可教机器的机器学习模型

- 具有可教机器的机器学习模型(1)

- 机器学习教程(1)

- 机器学习教程

📜 机器学习中的正则化

📅 最后修改于: 2020-09-29 05:24:44 🧑 作者: Mango

机器学习中的正则化

什么是正则化?

正则化是机器学习的最重要概念之一。它是一种通过向模型添加额外信息来防止模型过度拟合的技术。

有时,机器学习模型在训练数据上表现良好,但在测试数据上表现不佳。这意味着当通过在输出中引入噪声来处理看不见的数据时,该模型无法预测输出,因此该模型称为过拟合。可以借助正则化技术来解决此问题。

可以以某种方式使用该技术,该技术将允许通过减小变量的大小来维护模型中的所有变量或特征。因此,它保持了模型的准确性和通用性。

它主要将特征系数调整或减小为零。用简单的话说,“在正则化技术中,我们通过保持相同数量的特征来减小特征的大小。”

正则化如何工作?

正则化通过向复杂模型添加惩罚或复杂性项来进行。让我们考虑简单的线性回归方程:

在上式中,Y表示要预测的值

X1,X2,…Xn是Y的功能。

β0,β1,…βn分别是附加到特征的权重或大小。这里代表模型的偏差,b代表截距。

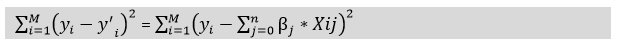

线性回归模型试图优化β0和b以最小化成本函数。线性模型成本函数的公式如下:

现在,我们将添加一个损失函数并优化参数,以创建可以预测Y精确值的模型。线性回归的损失函数称为RSS或残差平方和。

正则化技术

主要有两种类型的正则化技术,如下所示:

- 岭回归

- 套索回归

岭回归

- Ridge回归是线性回归的一种类型,其中引入了少量偏差,以便我们可以获得更好的长期预测。

- Ridge回归是一种正则化技术,可用于降低模型的复杂性。也称为L2正则化 。

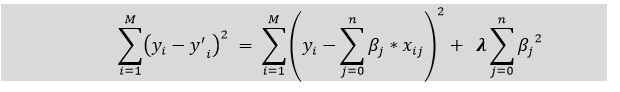

- 在这种技术中,成本函数是通过增加惩罚项来改变的。添加到模型的偏差量称为Ridge回归罚分 。我们可以通过将lambda乘以每个要素的权重的平方来计算。

- 岭回归中成本函数的方程式为:

- 在上式中,惩罚项使模型的系数正规化,因此,岭回归会减小系数的幅度,从而降低模型的复杂性。

- 从上面的方程式可以看出,如果λ的值趋于零,则该方程式成为线性回归模型的成本函数 。因此,对于λ的最小值,该模型将类似于线性回归模型。

- 如果自变量之间具有较高的共线性,则一般的线性或多项式回归将失败,因此可以使用Ridge回归来解决此类问题。

- 如果参数多于样本,则有助于解决问题。

套索回归:

- 套索回归是降低模型复杂性的另一种正则化技术。它代表最小绝对和选择运算符。

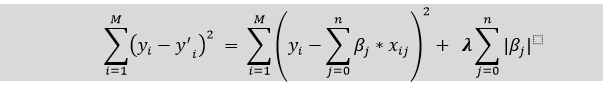

- 它与里奇回归相似,除了惩罚项仅包含绝对权重,而不是权重的平方。

- 由于它采用绝对值,因此可以将斜率缩小到0,而Ridge回归只能将其缩小到0。

- 也称为L1正则化。拉索回归的成本函数方程为:

- 该技术的某些功能在模型评估中被完全忽略。

- 因此,套索回归可以帮助我们减少模型中的过度拟合以及特征选择。

岭回归和套索回归之间的关键区别

- Ridge回归主要用于减少模型中的过拟合,它包括模型中存在的所有特征。它通过缩小系数来降低模型的复杂性。

- 套索回归有助于减少模型中的过度拟合以及特征选择。