大数据处理大数据集或处理传统数据处理应用软件处理的复杂问题。它具有三个关键概念,如数量、多样性和速度。在数量上,确定数据的大小和种类,数据将被分类意味着将确定数据的类型,如图像、PDF、音频、视频等;在速度方面,数据传输速度或处理和分析数据的速度将被考虑。大数据适用于大型数据集,它可以是非结构化、半结构化和结构化的。它在考虑大数据时包括以下关键参数,如捕获数据、搜索、数据存储、数据共享、传输、数据分析、可视化和查询等。 在分析的情况下,它将用于 A/B 测试,机器学习,自然语言处理等。 在可视化的情况下,将用于图表,图形等。 在大数据中,以下技术将用于商业智能,云计算和数据库等。

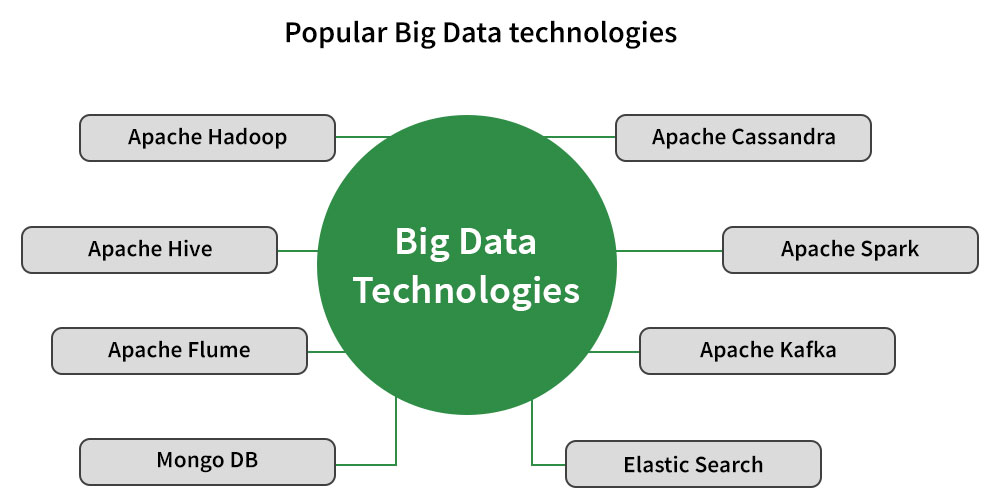

一些流行的大数据技术:

在这里,我们将详细讨论这些大数据技术的概述,并将主要集中在上面图中提到的每种技术的概述部分。

1. Apache Cassandra :它是No-SQL数据库之一,具有高度可扩展性和高可用性。在这种情况下,我们可以跨多个数据中心复制数据。支持跨多个数据中心的复制。在 Cassandra 中,容错是可以在不停机的情况下轻松更换故障节点的重要因素之一。

2. Apache Hadoop : Hadoop是应用最广泛的大数据技术之一,用于处理大规模数据,使用Hadoop文件系统(称为HDFS)处理大型文件系统,使用Hadoop的MapReduce框架进行并行处理等功能。 Hadoop 是一个可扩展的系统,有助于拥有处理大容量和大容量的可扩展解决方案。例如:如果您看到像 NextBio 这样的真实用例正在使用 Hadoop MapReduce 和 HBase 来处理来自人类基因组的多 TB 数据集。

3. Apache Hive :用于数据汇总和即席查询,即查询和分析简单的大数据。它构建在 Hadoop 之上,用于使用称为 HiveQL 的类 SQL 语言提供数据汇总、即席查询和大型数据集分析。它不是关系数据库,也不是用于实时查询的语言。它具有许多特性,如专为 OLAP 设计、称为 HiveQL 的 SQL 类型语言、快速、可扩展和可扩展。

4. Apache Flume:它是一个分布式的、可靠的系统,用于从多个数据源收集、聚合和移动大量日志数据到一个集中的数据存储。

5. Apache Spark : Spark的主要目标是加速 Hadoop 计算计算软件进程,由 Apache Software Foundation 推出。 Apache Spark 可以独立工作,因为它有自己的集群管理,并且它不是 Hadoop 的更新或修改版本,如果你会深入研究,那么你可以说它只是用 Hadoop 实现 Spark 的一种方式。以两种方式使用 Hadoop 实现 Spark 的主要思想是用于存储和处理。因此,Spark 以两种方式将 Hadoop 用于存储目的,因为 Spark 有自己的集群管理计算。在 Spark 中,它包括交互式查询和流处理,内存集群计算是关键特性之一。

6. Apache Kafka :它是一个分布式发布订阅消息系统,更具体地说,您可以说它有一个强大的队列,可以让您处理大量数据,并且您可以将消息从一个点传递到另一个点说从一个发送者到接收者。您可以在离线和在线模式下进行消息计算,两者都适用。为了防止数据丢失,Kafka 消息在集群内复制。对于实时流数据分析,它集成了 Apache Storm 和 Spark,并构建在 ZooKeeper 同步服务之上。

7. MongoDB :它是基于跨平台的,基于集合和文档的概念。它具有面向文档的存储,这意味着数据将以 JSON 形式存储。它可以是任何属性的索引。它具有高可用性、复制、丰富查询、MongoDB 支持、自动分片和快速就地更新等功能。

8. ElasticSearch :它是一个实时分布式系统,开源全文搜索和分析引擎。它具有可扩展性高、结构化和非结构化数据可扩展到PB级等特点,可替代MongoDB、基于文档存储的RavenDB。为了提高搜索性能,它使用了非规范化。如果您看到真正的用例,那么它是一个企业搜索引擎和使用它的大型组织,例如 – 维基百科、GitHub。