毫升 |评估指标

评价在任何领域总是好的对!在机器学习的情况下,这是最好的做法。在这篇文章中,我将几乎涵盖所有用于机器学习的流行和常用指标。

- 混淆矩阵

- 分类准确度。

- 对数损失。

- 曲线下的面积。

- F1分数。

- 平均绝对误差。

- 均方误差。

混淆矩阵:

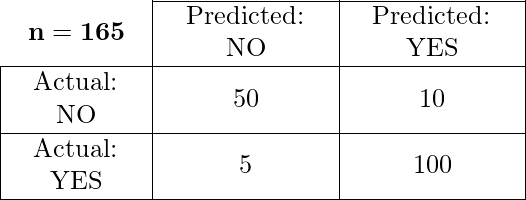

它创建一个NXN矩阵,其中 N 是要预测的类或类别的数量。这里我们有N = 2 ,所以我们得到2 X 2矩阵。假设我们的实践存在一个问题,即二元分类。该分类的样本属于Yes或No 。因此,我们构建了分类器,它将预测新输入样本的类别。之后,我们用165 个样本测试了我们的模型,我们得到了以下结果。

有4个术语你应该记住:

- 真阳性:在这种情况下,我们预测是,实际输出也是肯定的。

- True Negatives:情况是我们预测否,而实际输出也是否。

- 误报:这是我们预测是但实际上是否的情况。

- 假阴性:情况就是我们预测“否”但实际上是“是”。

矩阵的精度总是通过取主对角线中的平均值来计算,即

分类精度:

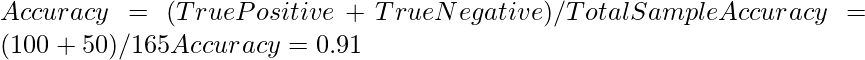

分类准确度是我们通常所说的准确度,每当我们使用准确度这个词时。我们通过计算正确预测与输入样本总数的比率来计算这一点。

![]()

如果每个类有相同数量的样本,则效果很好。例如,我们的训练集中有 90% 的A 类样本和 10% 的B 类样本。然后,我们的模型将通过预测所有训练样本属于A 类,以 90% 的准确率进行预测。如果我们用 A 类的 60% 和 B 类的 40% 的测试集来测试同一个模型。那么准确率会下降,我们会得到 60% 的准确率。

分类准确度很好,但它给 False Positive 带来了实现高精度的感觉。问题的出现是由于次要类样本的错误分类的可能性非常高。

对数损失。

它也被称为对数损失。它的基本工作宣传是通过惩罚假(假阳性)分类。它通常适用于多类分类。对数损失的工作,分类器应该为所有样本的每一类分配一个概率。如果有 N 个样本属于M类,那么我们这样计算 Log loss:

![]()

现在条款,

- y_ij表示样本i是否属于 j 类。

- p_ij——样本i属于 j 类的概率。

- 对数损失的范围是 [0,?)。当 log loss 接近 0 时,表示准确度高,当远离 0 时,表示准确度较低。

- 让我给你一个奖励点,最大限度地减少对数损失可以为分类器提供更高的准确性。

曲线下面积 (AUC):

它是广泛使用的指标之一,主要用于二进制分类。分类器的 AUC 定义为分类器将随机选择的正例排名高于负例的概率。在深入了解 AUC 之前,让我让您熟悉一些基本术语。

真阳性率:也称为或称为敏感性。真阳性率被认为是正确认为是阳性的阳性数据点的一部分,相对于所有阳性数据点。

![]()

真阴性率:也称为或称为特异性。假阴性率被认为是负数据点的一部分,这些数据点被正确地视为负数,相对于所有负数数据点。

![]()

假阳性率:假阴性率被认为是被错误地认为是阴性的阴性数据点的一部分,相对于所有阴性数据点。

![]()

假阳性率和真阳性率的值都在 [0, 1] 范围内。现在的问题是什么是 AUC?因此,AUC 是在 [0, 1] 范围内的所有不同数据点的假阳性率与真阳性率之间绘制的曲线。 AUCC 值越大,模型的性能越好。

AUC曲线

F1分数:

它是召回率和准确率之间的调和平均值。它的范围是[0,1]。该指标通常告诉我们分类器的精确度(它正确分类了多少实例)和鲁棒性(不会遗漏任何大量实例)。

It is used to measure the test’s accuracy

精确:

![]()

记起:

![]()

较低的召回率和较高的精度为您提供了很高的准确性,但它会错过大量实例。更多的F1分数更好的将是性能。它可以用这种方式在数学上表示:

![]()

平均绝对误差:

它是预测值和原始值之间的平均距离。基本上,它给出了我们从实际输出中预测的方式。然而,有一个限制,即它没有给出关于错误方向的任何想法,即我们是低估还是高估了我们的数据。它可以用这种方式在数学上表示:

![]()

均方误差:

它类似于平均绝对误差,但不同之处在于它取预测值和原始值之间平均值的平方。采用此度量的主要优势在于,计算梯度更容易,而在平均绝对误差的情况下,计算梯度需要复杂的编程工具。通过取误差的平方,它比较小的误差更能说明较大的误差,我们可以更多地关注较大的误差。它可以用这种方式在数学上表示:

![]()