robots.txt 文件

什么是 robots.txt 文件?

网面是一个开放的地方。几乎所有表面上的网站都可以被多个搜索引擎访问,例如,如果我们在 Google 中搜索某些内容,可以从中获得大量结果。但是,如果网页设计师在他们的网站上创建了一些东西并且不希望谷歌或其他搜索引擎访问它怎么办?这就是robots.txt文件发挥作用的地方。 Robots.txt 文件是设计者创建的一个文本文件,用于防止搜索引擎和机器人爬取他们的网站。它包含允许和不允许站点的列表,每当机器人想要访问该网站时,它都会检查 robots.txt 文件并仅访问那些被允许的站点。它不会在搜索结果中显示不允许的网站。

需要 robots.txt 文件:最重要的原因是为了让网站的整个部分保持私密,这样任何机器人都无法访问它。它还有助于防止搜索引擎索引某些文件。此外,它还指定站点地图的位置。

如何创建 robots.txt 文件?

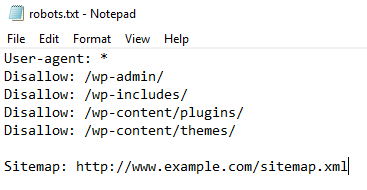

robots.txt 文件是放置在您的网络服务器上的简单文本文件,它告诉像 Google bot 这样的网络爬虫是否应该访问文件。该文件可以在记事本中创建。语法由下式给出:

User-agent: {name of user without braces}

Disallow: {site disallowed by the owner, i.e this can't be indexed}

Sitemap: {the sitemap location of the website}

组件说明:

- 用户代理: *

不允许:

该网站对所有搜索引擎(星号)开放,并且没有任何内容被禁止。 - 用户代理:Googlebot

不允许: /

不允许 Googlebot 搜索引擎为其任何内容编制索引。 - 用户代理: *

禁止:/file.html

这是部分访问。可以访问除 file.html 之外的所有其他内容。 - 参观时间:0200-0300

这限制了爬虫的时间。只能在给定的时间间隔之间对内容进行索引。 - 爬行延迟:20

禁止爬虫频繁访问站点,因为这会使站点变慢。

文件完成并准备好后,将其保存为名称“robots.txt”(这很重要,不要使用其他名称)并将其上传到网站的根目录。这将允许 robots.txt 文件完成其工作。

注意:互联网上的每个人都可以访问 robots.txt 文件。每个人都可以看到允许和不允许的用户代理和文件的名称。虽然没有人可以打开文件,但只显示文件的名称。

要检查网站的 robots.txt 文件,

“网站名称”+“/robots.txt” 例如:https://www.geeksforgeeks.org/robot.txt

robots.txt 文件是如何工作的?

在任何搜索引擎上搜索某些内容时,搜索机器人(作为用户代理)会找到该网站以显示结果。但在显示它之前,甚至在索引它之前,它会搜索网站的 robots.txt 文件(如果有的话)。如果有,搜索机器人会通过它检查网站上允许和不允许的站点。它会忽略文件中所有不允许的站点,并继续在结果中显示允许的内容。因此,它只能看到网站所有者允许的内容。

例子:

User-agent: Googlebot

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Crawl-delay: 20

Visit-time: 0200-0300

这意味着允许 Google bot 以 20 毫秒的延迟抓取每个页面,除了那些仅在 0200 – 0300 UTC 时间间隔内被禁止的 URL。

使用 robots.txt 文件的原因:

人们对在他们的网站中包含 robots.txt 文件有不同的看法。

拥有 robots.txt 文件的原因:

- 它阻止来自搜索引擎的内容。

- 它调整来自信誉良好的机器人对网站的访问。

- 用于目前正在开发的网站,不需要在搜索引擎中显示。

- 它用于将内容提供给特定的搜索引擎。

使用 robots.txt 文件?

robots.txt 文件最重要的用途是保护互联网的隐私。并非我们网页上的所有内容都应该向开放世界展示,因此这是一个严重的问题,可以通过 robots.txt 文件轻松处理。