Parsero – 在 Kali Linux 中读取 Robots.txt 文件的工具

Parsero是 GitHub 上提供的免费开源工具。 Parsero 用于读取网站和网络应用程序的 Robots.txt 文件。此工具可用于获取有关我们的目标(域)的信息。我们可以使用 Parsero 定位任何域。它有一个交互式控制台,可提供许多有用的功能,例如命令完成和上下文帮助。这个工具是用Python编写的,所以你必须在你的 Kali Linux 中安装Python才能使用这个工具。

它是一个Python脚本,用于在不允许的条目中读取实时 Web 服务器上的 Robots.txt 文件。当该工具开始工作时,这些不允许的条目会告诉搜索引擎哪些 HTML 文件或静态目录必须或不得编入索引。谷歌蜘蛛和爬虫在根据访问者数量为网站编制索引方面发挥着重要作用。管理员有责任不与搜索引擎共享私人和敏感信息。但有时这些开发人员会错误地允许搜索引擎访问 Robots.txt 文件。 Parsero 通过检查 Robots.txt 文件是否可见来帮助解决这种情况。

安装

步骤 1:使用以下命令安装 Parsero 工具。

apt install parsero

步骤2:该工具已下载并安装成功。现在,使用以下命令运行该工具。

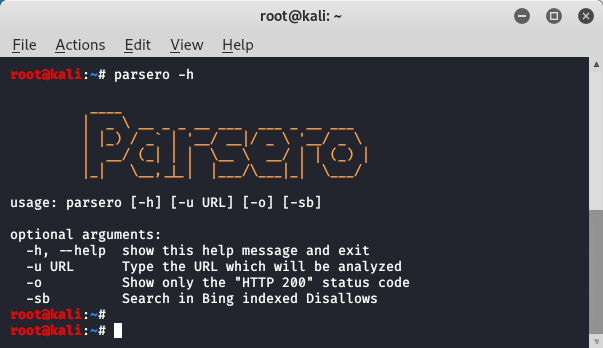

parsero -h

该工具正在成功运行。现在我们将看到一个使用该工具的示例。

用法

示例:使用 parsero 工具扫描任何网站。

parsero -u

这是您搜索目标的方式。该工具对于安全研究人员在渗透测试的初始阶段非常有用。您可以定位到您选择的任何域。