- COA |关联内存(1)

- COA |关联内存

- Python关联(1)

- Python关联

- 主内存

- 主内存(1)

- C++中的关联数组

- C++中的关联数组(1)

- 关联内存和高速缓存之间的差异(1)

- 关联内存和高速缓存之间的差异

- 关联内存和高速缓存之间的差异(1)

- 关联内存和高速缓存之间的差异

- PHP的关联数组(1)

- php 关联数组 (1)

- PHP的关联数组

- PHP关联数组(1)

- PHP关联数组

- 内存流到数组 (1)

- c# 字符串到内存流 - C# (1)

- 程序集-内存段(1)

- 程序集-内存段

- Python – 与字典中的值关联的键(1)

- Python – 与字典中的值关联的键

- D编程-关联数组

- D编程-关联数组(1)

- 关联 laravel - PHP 代码示例

- 主内存和辅助内存的区别

- 主内存和辅助内存的区别(1)

- 主内存和辅助内存的区别(1)

📅 最后修改于: 2020-11-26 08:36:28 🧑 作者: Mango

这些类型的神经网络基于模式关联进行工作,这意味着它们可以存储不同的模式,并且在提供输出时,可以通过将它们与给定的输入模式进行匹配来生成其中一种存储的模式。这些类型的存储器也称为内容可寻址存储器(CAM)。关联存储器使用存储的模式作为数据文件进行并行搜索。

以下是我们可以观察到的两种类型的联想记忆-

- 自动联想记忆

- 异联想记忆

自动联想记忆

这是单层神经网络,其中输入训练向量和输出目标向量相同。确定权重,以便网络存储一组模式。

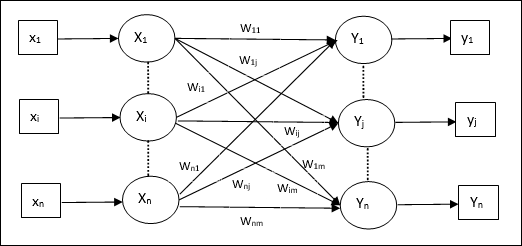

建筑

如下图所示,自动关联存储网络的体系结构具有“ n”个输入训练向量和相似的“ n”个输出目标向量。

训练算法

为了进行培训,该网络使用Hebb或Delta学习规则。

步骤1-将所有权重初始化为零,因为w ij = 0(i = 1至n,j = 1至n)

步骤2-对每个输入向量执行步骤3-4。

步骤3-如下激活每个输入单元-

$$ x_ {i} \:= \:s_ {i} \ 🙁 i \:= \:1 \:to \:n)$$

步骤4-如下激活每个输出单元-

$$ y_ {j} \:= \:s_ {j} \:((j \:= \:1 \:to \:n)$$

步骤5-如下调整权重-

$$ w_ {ij}(新)\:= \:w_ {ij}(旧)\:+ \:x_ {i} y_ {j} $$

测试算法

步骤1-设置训练过程中获得的权重以用于Hebb规则。

步骤2-对每个输入向量执行步骤3-5。

步骤3-将输入单元的激活设置为等于输入向量的激活。

步骤4-计算每个输出单元的净输入j = 1到n

$$ y_ {inj} \:= \:\ displaystyle \ sum \ limits_ {i = 1} ^ n x_ {i} w_ {ij} $$

步骤5-应用以下激活函数来计算输出

$$ y_ {j} \:= \:f(y_ {inj})\:= \:\开始{cases} +1&if \:y_ {inj} \:> \:0 \\-1&if \:y_ {inj} \:\ leqslant \:0 \ end {cases} $$

异联想记忆

与自动联想内存网络类似,这也是单层神经网络。但是,在该网络中,输入训练向量和输出目标向量不同。确定权重,以便网络存储一组模式。异类关联网络本质上是静态的,因此不会出现非线性和延迟操作。

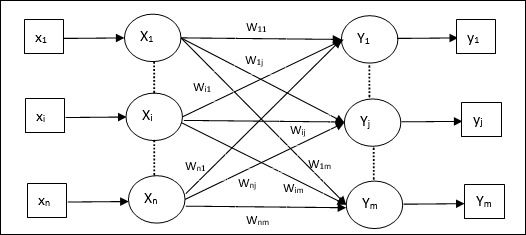

建筑

如下图所示,Hetero Associative Memory网络的架构具有“ n”个输入训练向量和“ m”个输出目标向量。

训练算法

为了进行培训,该网络使用Hebb或Delta学习规则。

步骤1-当w ij = 0(i = 1至n,j = 1至m)时将所有权重初始化为零

步骤2-对每个输入向量执行步骤3-4。

步骤3-如下激活每个输入单元-

$$ x_ {i} \:= \:s_ {i} \ 🙁 i \:= \:1 \:to \:n)$$

步骤4-如下激活每个输出单元-

$$ y_ {j} \:= \:s_ {j} \:((j \:= \:1 \:to \:m)$$

步骤5-如下调整权重-

$$ w_ {ij}(新)\:= \:w_ {ij}(旧)\:+ \:x_ {i} y_ {j} $$

测试算法

步骤1-设置训练过程中获得的权重以用于Hebb规则。

步骤2-对每个输入向量执行步骤3-5。

步骤3-将输入单元的激活设置为等于输入向量的激活。

步骤4-计算每个输出单元的净输入j = 1到m;

$$ y_ {inj} \:= \:\ displaystyle \ sum \ limits_ {i = 1} ^ n x_ {i} w_ {ij} $$

步骤5-应用以下激活函数来计算输出

$$ y_ {j} \:= \:f(y_ {inj})\:= \:\开始{cases} +1&if \:y_ {inj} \:> \:0 \\ 0&if \ :y_ {inj} \:= \:0 \\-1&if \:y_ {inj} \: