- Hadoop 与 R 编程语言的集成

- Hadoop 与 R 编程语言的集成(1)

- Hadoop-流

- Hadoop-流(1)

- hadoop 流 (1)

- Hadoop 1 和 Hadoop 2 之间的区别

- Hadoop 1 和 Hadoop 2 之间的区别(1)

- Hadoop 1 和 Hadoop 2 之间的区别

- Hadoop 2.x 与 Hadoop 3.x 之间的差异(1)

- Hadoop 2.x 与 Hadoop 3.x 之间的差异

- Hadoop 2.x 与 Hadoop 3.x 之间的差异(1)

- Hadoop 2.x 与 Hadoop 3.x 之间的差异

- hadoop 流 - 任何代码示例

- Hadoop安装

- Hadoop安装(1)

- Sqoop与Hadoop生态系统的集成(1)

- Sqoop与Hadoop生态系统的集成

- 什么是 Hadoop 流?(1)

- 什么是 Hadoop 流?

- 集成 - 任何代码示例

- Python的集成方法

- Python的集成方法(1)

- 使用 Hadoop 的数据

- 使用 Hadoop 的数据(1)

- Hadoop面试问题

- Hadoop面试问题(1)

- Hadoop教程(1)

- Hadoop教程

- Hadoop 教程(1)

📅 最后修改于: 2021-01-08 09:21:08 🧑 作者: Mango

与Hadoop的R集成

什么是Hadoop?

Hadoop是一个开放源代码框架,由ASF-Apache Software Foundation创建。它用于存储过程和分析海量数据。 Hadoop是用Java编写的,它不是OLAP(在线分析处理)。用于批处理/脱机处理。 Facebook,Google,Twitter,Yahoo,LinkedIn等都在使用它。而且,仅通过在集群中添加节点就可以扩大规模。

为什么将R与Hadoop集成?

R是一种开源编程语言。它最适合统计和图形分析。另外,如果我们需要强大的数据分析和可视化功能,则必须将R与Hadoop结合使用。

R和Hadoop集成的目的是:

- 使用Hadoop执行R代码。

- 使用R访问存储在Hadoop中的数据。

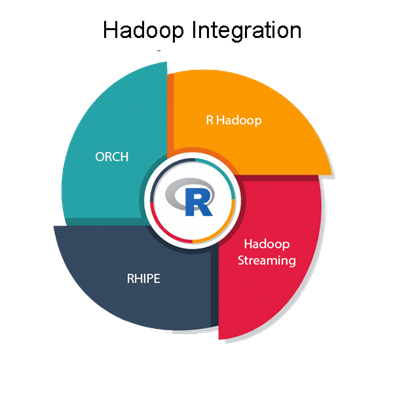

R Hadoop集成方法

Hadoop和R在大数据可视化和分析方面非常互补。一起使用Hadoop和R的四种方法如下:

R Hadoop

R Hadoop方法是软件包的集合。它包含三个软件包,即rmr,rhbase和rhdfs。

rmr软件包

对于Hadoop框架,rmr包通过在R中执行映射和缩减代码来提供MapReduce功能。

rhbase包

该软件包提供了与HBASE集成的R数据库管理功能。

rhdfs软件包

该软件包通过与HDFS集成来提供文件管理功能。

Hadoop流

Hadoop Streaming是一个实用程序,允许用户使用任何可执行文件作为映射器和/或精简器来创建和运行作业。使用流系统,我们可以使用足够的Java知识来开发可运行的Hadoop作业,以编写两个可协同工作的Shell脚本。

R和Hadoop的结合似乎是使用大型数据集和统计数据的人员的必备工具箱。但是,一些Hadoop爱好者在处理非常大的Big Data摘录时提出了一个警告。他们声称R的好处不是其语法,而是用于可视化和数据的整个原语库。这些库基本上是非分布式的,使数据检索成为一项耗时的事情。这是R的固有缺陷,如果您选择忽略它,则R和Hadoop可以一起工作。

瑞普

RHIPE代表R和Hadoop集成编程环境。 Divide and Recombine开发了RHIPE,用于高效分析大量数据。

RHIPE涉及使用R和Hadoop集成编程环境。我们可以使用Python,Perl或Java来读取RHIPE中的数据集。 RHIPE中有多种功能,可让HDFS与HDFS进行交互。因此,通过这种方式,我们可以读取,保存使用RHIPE MapReduce创建的完整数据。

ORCH

ORCH被称为Oracle R连接器。该方法特别用于Oracle设备中的大数据。它还可用于非Oracle框架(如Hadoop)。

该方法有助于在R的帮助下访问Hadoop集群,还有助于编写映射和归约函数。它使我们能够处理Hadoop分布式文件系统中的数据。