- ai (1)

- ai - 任何代码示例

- C#-环境

- C#-环境(1)

- 制作 ai 的代码 (1)

- 什么是代理 (1)

- 用Python讨论AI(1)

- 用Python讨论AI

- JavaScript 中的类和代理是什么?

- JavaScript 中的类和代理是什么?(1)

- JavaScript |代理()对象

- JavaScript |代理()对象(1)

- 什么代码用于 ai (1)

- ai 到 png (1)

- 带Python的AI –入门(1)

- 带Python的AI –入门

- 假用户代理 python (1)

- python的用户代理(1)

- 代理设置 - 任何代码示例

- ai 2001 (1)

- AI 挑战 (1)

- 制作 ai 的代码 - 任何代码示例

- 代理请求python(1)

- 带有Python的AI教程

- 带有Python的AI教程(1)

- DBMS 中的代理键

- 什么是代理 - 无论代码示例

- 如何在 sql 中重置 AI(1)

- 假用户代理 python 代码示例

📅 最后修改于: 2021-01-23 05:41:31 🧑 作者: Mango

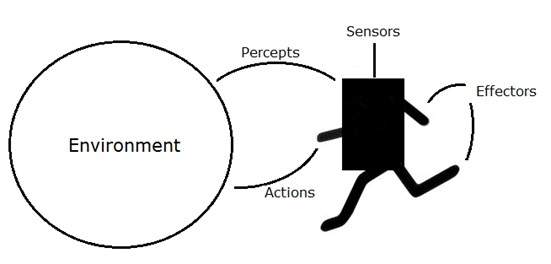

AI系统由代理及其环境组成。代理在其环境中行动。该环境可能包含其他代理。

什么是代理和环境?

代理是可以通过传感器感知其环境并通过效应器在该环境上起作用的任何事物。

-

人类试剂具有与传感器平行的感觉器官,例如眼睛,耳朵,鼻子,舌头和皮肤,以及其他器官,例如效应器的手,腿,嘴。

-

机器人代理代替了用于传感器的照相机和红外测距仪,以及用于效应器的各种电机和致动器。

-

软件代理已将位字符串编码为其程序和动作。

代理术语

-

代理的绩效评估-这是确定代理成功与否的标准。

-

代理的行为-这是代理在任何给定的感知序列之后执行的动作。

-

感知-它是给定实例上智能体的感知输入。

-

感知序列-这是代理迄今为止所感知的所有历史。

-

代理功能-它是从规约序列到动作的映射。

理性

理性不过是理性,明智和具有良好判断力的状态。

理性与预期行为和结果有关,取决于代理人的感知。采取旨在获得有用信息的行动是合理性的重要组成部分。

什么是理想的Rational Agent?

理想的理性主体是能够在以下基础上采取预期行动以最大化其绩效指标的主体:

- 它的感知顺序

- 内置的知识库

代理的合理性取决于以下内容-

-

绩效指标,决定成功的程度。

-

特工的感知序列到现在为止。

-

代理对环境的先验知识。

-

代理可以执行的动作。

理性主体总是执行正确的动作,其中正确的动作是指导致主体在给定的感知序列中最成功的动作。代理解决的问题以性能度量,环境,执行器和传感器(PEAS)为特征。

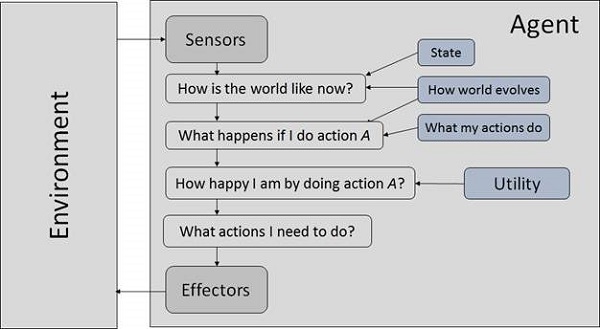

智能代理的结构

代理的结构可以看成是-

- 代理=体系结构+代理程序

- 体系结构=代理执行的机器。

- 代理程序=代理函数的实现。

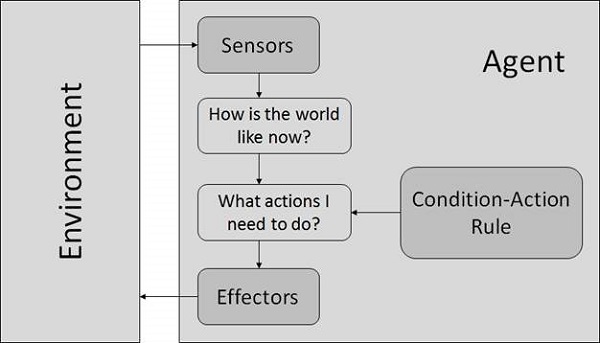

简单的反射剂

- 他们仅根据当前的感知选择动作。

- 仅当仅根据当前戒律做出正确决定时,它们才是合理的。

- 他们的环境是完全可以观察到的。

条件-动作规则-这是将状态(条件)映射到动作的规则。

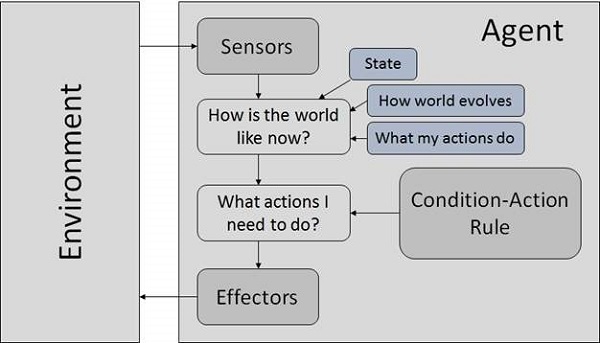

基于模型的反射代理

他们使用世界模型来选择自己的行动。他们保持内部状态。

模型-有关“事物如何在世界上发生”的知识。

内部状态-根据感知历史记录,它是当前状态未观察到的方面的表示。

更新状态需要有关以下信息:

- 世界如何演变。

- 代理人的行为如何影响世界。

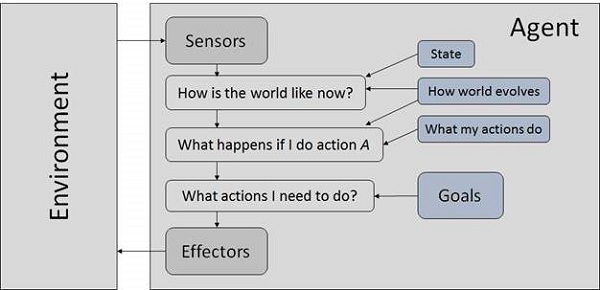

目标代理

他们选择自己的行动以实现目标。基于目标的方法比自反代理更灵活,因为对支持决策的知识进行了显式建模,从而可以进行修改。

目标-描述理想情况。

基于实用程序的代理

他们根据每个州的偏好(效用)选择操作。

在以下情况下目标不足:

-

有相互矛盾的目标,其中只有很少的目标可以实现。

-

目标的实现存在不确定性,您需要权衡成功的可能性和目标的重要性。

环境的本质

一些程序在完全人工的环境中运行,仅限于键盘输入,数据库,计算机文件系统和屏幕上的字符输出。

相反,某些软件代理(软件机器人或软件机器人)存在于丰富的,无限的软件机器人域中。该模拟器具有非常详细,复杂的环境。软件代理需要实时从多种操作中进行选择。设计用于扫描客户在线偏好并向客户展示有趣项目的软件机器人可以在真实环境和人工环境中工作。

最著名的人工环境是图灵测试环境,在该环境中,一种真实的人工代理和其他人工代理在相同的地面上进行测试。这是一个非常具有挑战性的环境,因为软件代理要像人类一样很难执行。

图灵测试

系统智能行为的成功可以通过Turing Test进行衡量。

两个人和一台要评估的机器参与测试。在这两个人中,有一个扮演测试者的角色。他们每个人都坐在不同的房间里。测试人员不知道谁是机器,谁是人。他通过键入问题并将其发送给两个情报来询问这些问题,然后他收到键入的答复。

该测试旨在欺骗测试人员。如果测试人员无法根据人的反应来确定机器的反应,则认为机器是智能的。

环境性质

环境具有多重属性-

-

离散/连续-如果存在有限数量的清晰,明确定义的环境状态,则环境是离散的(例如国际象棋);否则,它是连续的(例如,驾驶)。

-

可观察/部分可观察-如果可以根据感知确定每个时间点的完整环境状态,则可观察;否则只能部分观察到。

-

静态/动态-如果代理在操作时环境没有变化,则它是静态的;否则它是动态的。

-

单个代理程序/多个代理程序-环境中可能包含与该代理程序类型相同或不同的其他代理程序。

-

可访问/不可访问-如果代理的感觉设备可以访问环境的完整状态,则该代理可以访问该环境。

-

确定性/非确定性-如果环境的下一个状态完全由当前状态和代理的行为确定,则环境是确定性的;否则,它是不确定的。

-

情节/非情节-在情节环境中,每个情节都由主体感知然后行动。其动作的质量仅取决于情节本身。后续情节不取决于先前情节中的动作。情景环境要简单得多,因为代理不需要提前考虑。