Q-learning数学背景

先决条件: Q-Learning。

在以下推导中,将使用先决条件文章中定义的符号。

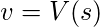

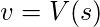

Q 学习技术基于贝尔曼方程。

![]()

在哪里,

E : 期望

t+1 : 下一个状态![]() : 折扣系数

: 折扣系数

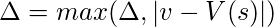

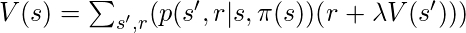

以 Q 值的形式重新表述上述方程:-

![]()

![]()

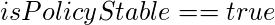

最佳 Q 值由下式给出

![]()

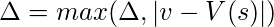

策略迭代:这是为模型确定最优策略的过程,包括以下两个步骤:-

- 策略评估:此过程使用从最后一个策略改进步骤获得的贪婪策略估计长期奖励函数的值。

- 策略改进:此过程使用使每个状态的 V 最大化的操作来更新策略。重复这个过程,直到达到收敛。

涉及的步骤:-

- 初始化:

= 任何实随机数

= 任何实随机数 = 任意选择的任何 A(s)

= 任意选择的任何 A(s) - 政策评估:

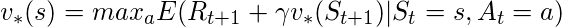

尽管(

尽管(  ) {对于 S 中的每个 s {

) {对于 S 中的每个 s {

} }

} }

- 政策改进:

while(true)对于 S 中的每个 s {

while(true)对于 S 中的每个 s {

如果(

如果(  )

)  如果(

如果(  )从两个循环中中断}返回 V,

)从两个循环中中断}返回 V,

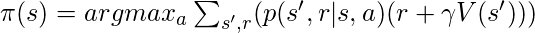

- 值迭代:此过程根据最优贝尔曼方程更新函数V。

工作步骤:

- 初始化:用任意随机实数初始化数组 V。

- 计算最优值:

尽管(

尽管(  ) {对于 S 中的每个 s {

) {对于 S 中的每个 s {

} }

} }  返回

返回