- 高级 C++ 主题 - C++ (1)

- 高级 C++ 主题 - C++ 代码示例

- 遗传算法

- 遗传算法教程

- 遗传算法教程(1)

- 遗传算法-简介(1)

- 遗传算法-简介

- 讨论遗传算法

- 讨论遗传算法(1)

- 遗传算法-基础

- 遗传算法-基础(1)

- 遗传算法-交叉(1)

- 遗传算法-交叉

- 遗传算法中的交叉

- 遗传算法中的交叉(1)

- 主题 (1)

- 带Python的AI –遗传算法

- 带Python的AI –遗传算法(1)

- 遗传算法-有用的资源

- 遗传算法-有用的资源(1)

- 人工神经网络-遗传算法

- 人工神经网络-遗传算法(1)

- 遗传算法-变异(1)

- 遗传算法-变异

- 遗传算法的旅行商问题(1)

- 遗传算法的旅行商问题

- (无主题) - Javascript (1)

- 遗传算法-父级选择

- 遗传算法-父级选择(1)

📅 最后修改于: 2020-11-24 07:13:16 🧑 作者: Mango

在本节中,我们介绍了遗传算法中的一些高级主题。希望仅阅读GA简介的读者可以选择跳过此部分。

约束优化问题

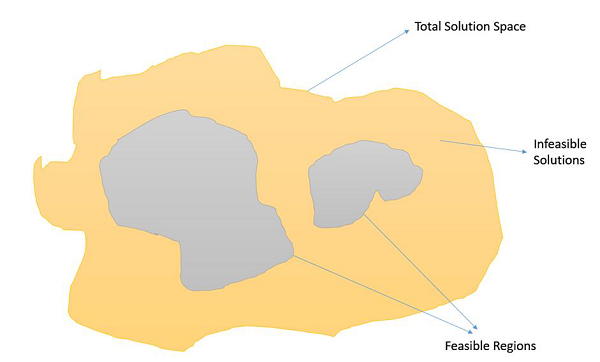

约束优化问题是那些我们必须最大化或最小化受某些约束约束的给定目标函数值的那些优化问题。因此,并非解决方案空间中的所有结果都是可行的,并且解决方案空间包含可行的区域,如下图所示。

在这种情况下,交叉和变异运算符可能会为我们提供不可行的解决方案。因此,在处理约束优化问题时,GA中必须采用其他机制。

一些最常见的方法是-

-

优选使用惩罚函数,其降低不可行解决方案的适用性,优选地,使得适用性与违反的约束的数量或与可行区域的距离成比例地降低。

-

使用采用不可行解决方案并对其进行修改的修复功能,以使违反的约束得到满足。

-

根本不允许不可行的解决方案进入人群。

-

使用特殊的表示或解码器功能,以确保解决方案的可行性。

基本理论背景

在本节中,我们将讨论Schema和NFL定理以及构件假设。

图式定理

研究人员一直在试图找出遗传算法工作背后的数学原理,而荷兰的图式定理就是朝这个方向迈出的一步。在过去的一年中,已对模式定理进行了各种改进和建议,以使其更通用。

在本节中,我们不会深入研究模式定理的数学,而是尝试对模式定理是什么有一个基本的了解。要了解的基本术语如下-

-

模式是一个“模板”。形式上,它是字母= {0,1,*}上的字符串,

*无关紧要,可以取任何值。

因此,* 10 * 1可能表示01001、01011、11001或11011

从几何上讲,方案是解决方案搜索空间中的超平面。

-

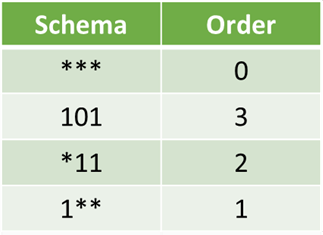

模式的顺序是基因中指定的固定位置的数量。

-

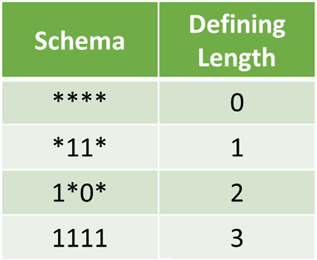

定义长度是基因中两个最远的固定符号之间的距离。

模式定理指出,具有较高平均适应度,较短的定义长度和较低阶的此模式更可能幸免于交叉和变异。

构件假设

构造块是具有上述给定的平均适合度的低阶,低定义长度的方案。构建块假设说,随着构建块通过逐步识别和重新组合这些“构建块”,这些构建块成为GA成功和适应GA的基础。

没有免费午餐(NFL)定理

Wolpert和Macready在1997年发表了一篇题为“没有免费的午餐定理进行优化”的论文。本质上说,如果我们对所有可能问题进行平均,那么所有非重访黑盒算法将表现出相同的性能。

这意味着,我们对问题的了解越多,我们的遗传算法就越具有针对性,并且性能更好,但是通过在其他问题上的表现较差来弥补这一点。

基于GA的机器学习

遗传算法还可以在机器学习中找到应用。分类器系统是一种基于遗传的机器学习(GBML)系统,在机器学习领域中经常使用。 GBML方法是机器学习的利基方法。

GBML系统分为两类-

-

匹兹堡方法-在这种方法中,一条染色体编码一个溶液,因此将适应度分配给溶液。

-

密歇根方法-一种解决方案通常由许多染色体代表,因此将适应度分配给部分解决方案。

应当记住,GBML系统中也存在诸如交叉,变异,Lamarckian或Darwinian等的标准问题。