- 基本概念

- 基本概念(1)

- 人工神经网络(1)

- 人工神经网络

- Git-基本概念

- Git-基本概念(1)

- 网络-基本概念(1)

- 网络-基本概念

- 人工神经网络教程(1)

- 人工神经网络教程

- TensorFlow 中的人工神经网络(1)

- TensorFlow 中的人工神经网络

- TensorFlow中的人工神经网络(1)

- TensorFlow中的人工神经网络

- 人工神经网络-构建块(1)

- 人工神经网络-构建块

- 讨论人工神经网络

- 讨论人工神经网络(1)

- CodeIgniter-基本概念(1)

- CodeIgniter-基本概念

- 基本概念和术语

- 基本概念和术语(1)

- 人工神经网络术语

- Elasticsearch-基本概念(1)

- Elasticsearch-基本概念

- DynamoDB-基本概念

- DynamoDB-基本概念(1)

- Bokeh-基本概念(1)

- Bokeh-基本概念

📅 最后修改于: 2020-11-26 08:24:05 🧑 作者: Mango

神经网络是并行计算设备,基本上是对大脑进行计算机模型化的尝试。主要目标是开发一种比传统系统更快地执行各种计算任务的系统。这些任务包括模式识别和分类,近似,优化和数据聚类。

什么是人工神经网络?

人工神经网络(ANN)是一种高效的计算系统,其中心主题是从生物神经网络的类比中借鉴而来的。人工神经网络也被称为“人工神经系统”或“并行分布式处理系统”或“连接系统”。 ANN获取大量的单元,这些单元以某种模式互连以允许单元之间的通信。这些单元,也称为节点或神经元,是并行运行的简单处理器。

每个神经元通过连接链接与其他神经元连接。每个连接链接都与具有有关输入信号信息的权重关联。这对于神经元解决特定问题是最有用的信息,因为重量通常会激发或抑制正在传达的信号。每个神经元都有一个内部状态,称为激活信号。组合输入信号和激活规则后产生的输出信号可以发送到其他单元。

人工神经网络简史

ANN的历史可以分为以下三个时代-

1940到1960年代的人工神经网络

这个时代的一些关键发展如下-

-

1943年-假设神经网络的概念始于生理学家沃伦·麦卡洛克(Warren McCulloch)和数学家沃尔特·皮茨(Walter Pitts)的工作,当时,他们在1943年使用电路为简单的神经网络建模,以描述大脑中的神经元如何工作。

-

1949年-唐纳德·赫布(Donald Hebb)的著作《行为的组织》( The Organisation of Behavior )提出了这样一个事实,即每次使用一个神经元时,另一个神经元反复激活都会增强其强度。

-

1956年-泰勒(Taylor)引入了联想存储网络。

-

1958年-Rosenblatt发明了一种名为Perceptron的McCulloch和Pitts神经元模型的学习方法。

-

1960年-Bernard Widrow和Marcian Hoff开发了名为“ ADALINE”和“ MADALINE”的模型。

1960年代至1980年代的人工神经网络

这个时代的一些关键发展如下-

-

1961年– Rosenblatt进行了一次失败的尝试,但提出了多层网络的“反向传播”方案。

-

1964年-泰勒(Taylor)建造了一个赢家通吃的赛道,但输出单元之间受到了限制。

-

1969年-Minsky和Papert发明了多层感知器(MLP)。

-

1971年– Kohonen开发了联想记忆。

-

1976年-Stephen Grossberg和Gail Carpenter开发了自适应共振理论。

从1980年代至今的人工神经网络

这个时代的一些关键发展如下-

-

1982年-主要的发展是Hopfield的能源方法。

-

1985年-Ackley,Hinton和Sejnowski开发了Boltzmann机器。

-

1986年-Rumelhart,Hinton和Williams引入了通用三角洲规则。

-

1988年-Kosko开发了二进制联想记忆(BAM),并在ANN中提出了模糊逻辑的概念。

历史回顾表明,该领域已取得重大进展。基于神经网络的芯片正在出现,并且正在开发针对复杂问题的应用程序。当然,今天是神经网络技术过渡的时期。

生物神经元

神经细胞(神经元)是一种处理信息的特殊生物细胞。根据估计,存在大量的神经元,大约10 11且具有许多互连,大约10 15 。

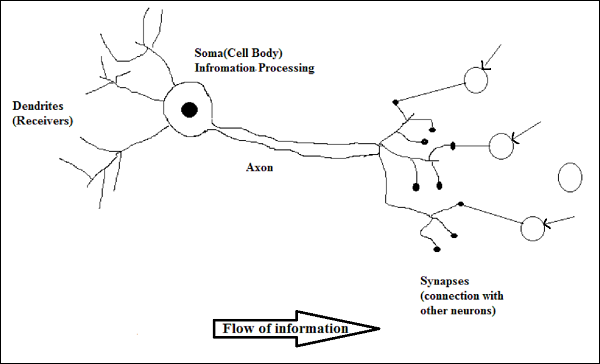

原理图,示意图

生物神经元的工作

如上图所示,典型的神经元由以下四个部分组成,借助这些部分,我们可以解释其工作原理-

-

树突-它们是树状分支,负责从与其连接的其他神经元接收信息。换句话说,我们可以说它们就像神经元的耳朵。

-

Soma-它是神经元的细胞体,负责处理来自树突的信息。

-

轴突-就像神经元通过其发送信息的电缆一样。

-

突触-这是轴突和其他神经元树突之间的连接。

人工神经网络与神经网络

在查看人工神经网络(ANN)和生物神经网络(BNN)之间的差异之前,让我们基于这两者之间的术语,来研究两者的相似性。

| Biological Neural Network (BNN) | Artificial Neural Network (ANN) |

|---|---|

| Soma | Node |

| Dendrites | Input |

| Synapse | Weights or Interconnections |

| Axon | Output |

下表根据提到的一些标准显示了ANN和BNN之间的比较。

| Criteria | BNN | ANN |

|---|---|---|

| Processing | Massively parallel, slow but superior than ANN | Massively parallel, fast but inferior than BNN |

| Size | 1011 neurons and 1015 interconnections | 102 to 104 nodes (mainly depends on the type of application and network designer) |

| Learning | They can tolerate ambiguity | Very precise, structured and formatted data is required to tolerate ambiguity |

| Fault tolerance | Performance degrades with even partial damage | It is capable of robust performance, hence has the potential to be fault tolerant |

| Storage capacity | Stores the information in the synapse | Stores the information in continuous memory locations |

人工神经网络模型

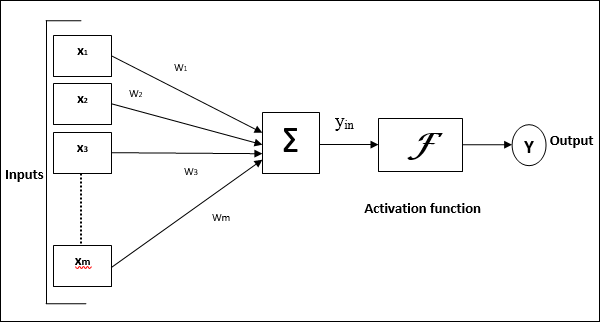

下图显示了ANN的一般模型及其处理。

对于上面的人工神经网络通用模型,净输入可以计算如下:

$$ y_ {in} \:= \:x_ {1} .w_ {1} \:+ \:x_ {2} .w_ {2} \:+ \:x_ {3} .w_ {3} \: \ dotso \:x_ {m} .w_ {m} $$

即,净输入$ y_ {in} \:= \:\ sum_i ^ m \:x_ {i} .w_ {i} $

可以通过将激活函数应用于净输入来计算输出。

$$ Y \:= \:F(y_ {in})$$

输出=函数(计算出的净输入)