先决条件:降维简介

降维是通过获取一组主变量来减少所考虑的随机变量数量的过程。它可以分为特征选择和特征提取。

降维是预测建模中的重要因素。各种提出的方法已经通过图形或通过诸如过滤,包装或嵌入的各种其他方法引入了不同的方法来这样做。但是,大多数这些方法都是基于一些阈值和基准算法,这些阈值和基准算法确定数据集中要素的最优性。

减少维度的一种动机是,更高维度的数据集会增加时间复杂度,并且所需空间也会更大。同样,数据集中的所有功能可能都没有用。有些可能根本不贡献任何信息,而有些则可能贡献与其他功能相似的信息。选择最佳的特征集将帮助我们减少空间和时间的复杂性,并分别增加有监督学习和无监督学习的分类(或回归)和聚类(或关联)的准确性或纯度。

特征选择具有四种不同的方法,例如过滤器方法,包装器方法,嵌入式方法和混合方法。

- 包装方法:

- 过滤方法:通过该方法选择特征子集,而无需使用任何学习算法。高维数据集使用此方法,它比基于包装器的方法相对更快。

- 嵌入式方法:应用的学习算法确定该方法的特殊性,并在训练数据集的过程中选择功能。

- 混合方法:混合方法中同时使用了基于过滤器和包装器的方法。该方法首先选择可能的最佳功能集,然后由包装器方法对其进行进一步测试。因此,它利用了基于过滤器和基于包装器的方法的优点。

这种方法具有很高的计算复杂度。它使用学习算法来评估通过使用分类中的所选特征所产生的准确性。包装器方法可以为特定分类器提供较高的分类精度。

特征选择参数:

参数基于两个因素进行分类–

信息的相似性是由这些功能贡献的:

1.相关性

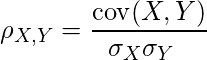

主要根据特征的相关因子将特征分类为关联或相似。在数据集中,我们具有许多相互关联的功能。现在,具有相关特征的问题是,如果f1和f2是数据集的两个相关特征,则与f1或f2场景相比,包括f1和f2的分类或回归模型将提供与预测模型相同的结果。 f2已包含在数据集中。这是因为f1和f2都相关,因此它们在数据集中提供了有关模型的相同信息。有多种计算相关因子的方法,但是,Pearson相关系数被最广泛地使用。皮尔逊相关系数的公式( ![]() ) 是:

) 是:

where

cov(X, Y) - covariance

sigma(X) - standard deviation of X

sigma(Y) - standard deviation of Y因此,相关特征无关紧要,因为它们都贡献了相似的信息。整个相关或关联特征中只有一个代表会给出相同的分类或回归结果。因此,在使用各种算法从每个关联或相关的特征组中选择特定代表之后,这些特征是多余的,并且出于降维的目的而被排除在外。这些功能贡献的信息量:

1.熵

熵是平均信息含量的量度。熵越高,该特征对信息的贡献就越高。熵(H)可以表示为:

![]()

where

X - discrete random variable X

P(X) - probability mass function

E - expected value operator,

I - information content of X.

I(X) - a random variable.在数据科学中,特征f1的熵是通过排除特征f1然后计算其余特征的熵来计算的。现在,熵值(不包括f1)越低,f1的信息内容就越高。以这种方式,计算了所有特征的熵。最后,阈值或进一步的相关性检查会根据选择的特征确定特征的最佳性。熵主要用于无监督学习,因为我们在数据集中确实有一个类字段,因此特征的熵可以提供大量信息。

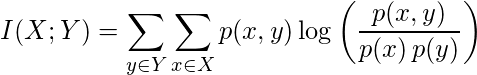

2.相互信息

在信息论中,互信息I(X; Y)是由于Y的知识而导致的X中的不确定性量。在数学上,互信息被定义为

where

p(x, y) - joint probability function of X and Y,

p(x) - marginal probability distribution function of X

p(y) - marginal probability distribution function of Y数据科学中的互信息主要是为了了解某个功能所共享的有关该类的信息量而进行的。因此,它主要用于监督学习中的降维。在监督学习中具有与类相对应的高互信息值的特征被认为是最优的,因为它们可以影响预测模型朝着正确的预测方向,从而提高模型的准确性。参考: http://www.cs.uccs.edu/~jkalita/papers/2014/HoqueExpertSystems2014.pdf