集成分类器 |数据挖掘

集成学习通过组合多个模型来帮助改善机器学习结果。与单个模型相比,这种方法允许产生更好的预测性能。基本思想是学习一组分类器(专家)并让他们投票。

Advantage : Improvement in predictive accuracy.

Disadvantage : It is difficult to understand an ensemble of classifiers.

为什么合奏会起作用?

Dietterich (2002) 表明集成克服了三个问题——

- 统计问题——

当假设空间对于可用数据量来说太大时,就会出现统计问题。因此,在数据上有许多具有相同准确性的假设,而学习算法仅选择其中之一!存在一种风险,即所选假设的准确性在看不见的数据上很低! - 统计问题——

当学习算法不能保证找到最佳假设时,就会出现计算问题。 - 代表性问题——

当假设空间不包含目标类的任何良好近似时,就会出现表征问题。

开发集成模型的主要挑战是什么?

主要的挑战不是获得高度准确的基础模型,而是获得产生不同类型错误的基础模型。例如,如果使用集成进行分类,如果不同的基模型对不同的训练样本进行错误分类,即使基分类器的准确率很低,也可以实现高准确率。

Methods for Independently Constructing Ensembles –

- Majority Vote

- Bagging and Random Forest

- Randomness Injection

- Feature-Selection Ensembles

- Error-Correcting Output Coding

Methods for Coordinated Construction of Ensembles –

- Boosting

- Stacking

Reliable Classification: Meta-Classifier Approach

Co-Training and Self-Training

集成分类器的类型 -

装袋:

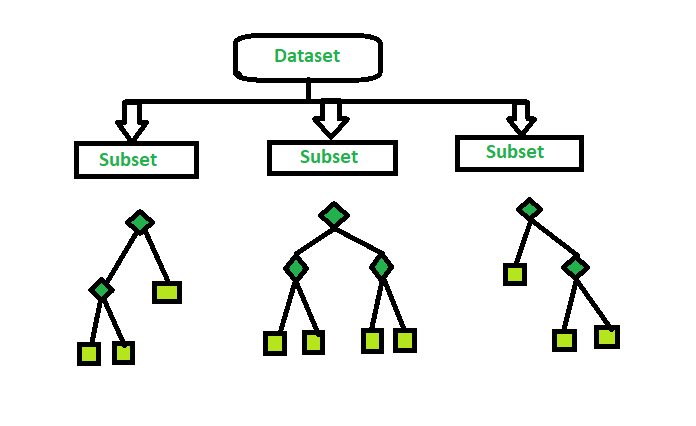

Bagging(Bootstrap Aggregation)用于减少决策树的方差。假设有 d 个元组的集合 D,在每次迭代i 时,d 个元组的训练集 D i被采样,并从 D 中替换(即引导)。然后分类器模型M i的学习对每个训练集d的

Bagging的实现步骤——

- 从具有相等元组的原始数据集创建多个子集,通过替换选择观察。

- 在这些子集中的每一个上创建一个基本模型。

- 每个模型都是从每个训练集中并行学习的,并且彼此独立。

- 最终的预测是通过结合所有模型的预测来确定的。

随机森林:

随机森林是对装袋的扩展。集成中的每个分类器都是一个决策树分类器,并使用在每个节点上随机选择的属性来确定拆分来生成。在分类过程中,每棵树投票,并返回最受欢迎的类。随机森林的实现步骤——

- 从原始数据集创建多个子集,选择替换观察。

- 随机选择一个特征子集,并使用给出最佳分割的特征来迭代地分割节点。

- 这棵树长到最大。

- 重复上述步骤,根据来自 n 个树的预测的聚合给出预测。

您可以在 sklearn 文档中了解更多信息。