神经网络中偏差的影响

神经网络在概念上基于大脑的实际神经元。神经元是大型神经网络的基本单元。单个神经元根据提供的输入向前传递。

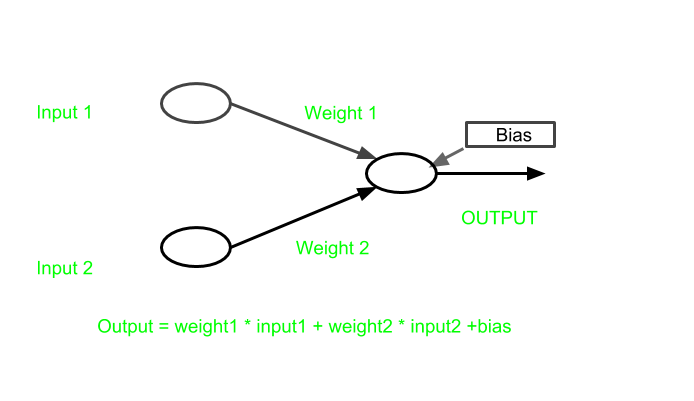

在神经网络中,一些输入被提供给人工神经元,每个输入都关联一个权重。权重增加了激活函数的陡度。这意味着权重决定激活函数的触发速度,而偏置用于延迟激活函数的触发。

对于典型的神经元,如果输入是 x1、x2 和 x3,则要应用于它们的突触权重表示为 w1、w2 和 w3。

输出是

y = f(x) = Σxiwi

y = f(x) = Σxiwi

其中 i 是输入数量的 1。

权重显示特定输入的有效性。输入的权重越大,对网络的影响就越大。

另一方面,偏差就像在线性方程中添加的截距。它是神经网络中的一个附加参数,用于调整输出以及神经元输入的加权和。因此,偏差是一个常数,它以一种最适合给定数据的方式帮助模型。

因此,神经元完成的处理表示为:

output = sum (weights * inputs) + bias

output = sum (weights * inputs) + bias

需要偏见

在上图中

y = mx+c在哪里

m = weight和

c = bias现在,假设如果 c 不存在,那么图形将形成如下:

由于没有偏差,模型将仅在通过原点的点上进行训练,这与现实世界场景不符。此外,随着偏差的引入,模型将变得更加灵活。

例如:

假设一个激活函数act() 在某个大于 0 的输入上被触发。

现在,

input1 = 1weight1 = 2input2 = 2weight2 = 2所以

output = input1*weight1 + input2*weight2output = 6让

suppose act(output) = 1现在在输出中引入了一个偏差

bias = -6输出变为0。

act(0) = 0所以激活函数不会触发。

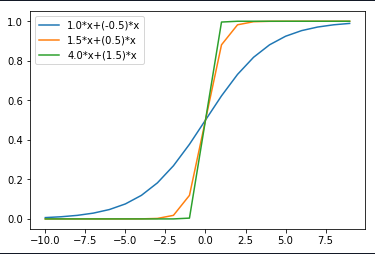

体重变化

在图中,可以看出,当:

- 重量WI

changed from 1.0 to 4.0 - 重量 W2

changed from -0.5 to 1.5

随着重量的增加,陡度也在增加。

因此可以推断出

More the weight earlier activation function will trigger.

偏见的变化

在下图中,当

Bias changed from -1.0 to -5.0偏差的变化正在增加触发激活函数的值。

因此可以从上图中推断,

bias helps in controlling the value at which activation function will trigger.