PCA的数学方法

什么是PCA?

主成分分析的主要指导原则是特征提取,即“数据集的特征应该较少,彼此之间的相似性也非常少。”在 PCA 中,从本质上非常不同的原始特征中提取一组新的特征。因此,一个n 维特征空间被转换为一个m 维特征空间。 ,其中维度彼此正交。

正交性的概念:

(为了理解这个话题,我们必须去了解线性代数中的向量空间概念)向量空间是一组向量。它们可以表示为称为BASIS VECTORS 的较小向量集的线性组合。所以向量空间中的任何向量“v”都可以表示为:

![]()

其中a表示“n”个标量,u 表示基向量。基向量彼此正交。向量的正交性可以被认为是向量在二维向量空间中垂直的延伸。所以我们的特征向量(数据集)可以转换成一组主成分(就像基向量一样)。

PCA的目标:

- 新特征是不同的,即新特征(在 PCA 的情况下,它们是主成分)之间的协方差为0 。

- 主成分是按照它捕获的数据的可变性的顺序生成的。因此,第一个主成分应该捕获最大的可变性,第二个应该捕获次高的可变性等。

- 新特征/主成分的方差之和应该等于原始特征的方差之和。

PCA的工作:

PCA 处理称为数据集协方差矩阵的特征值分解的过程。步骤如下:

- 首先,计算数据集的协方差矩阵。

- 然后,计算协方差矩阵的特征向量。

- 具有最高特征值的特征向量表示存在最大方差的方向。所以这将有助于识别第一个主成分。

- 具有次高特征值的特征向量表示数据具有最高剩余方差并且还与第一方向正交的方向。因此,这有助于识别第二个主成分。

- 像这样, 识别具有前“k”个特征值的前“k”个特征向量以获得“k”个主成分。

PCA 的数值:

考虑以下数据集x1 2.5 0.5 2.2 1.9 3.1 2.3 2.0 1.0 1.5 1.1 x2 2.4 0.7 2.9 2.2 3.0 2.7 1.6 1.1 1.6 0.9

步骤 1:标准化数据集

均值![]() = 1.81 =

= 1.81 =

均值![]() = 1.91 =

= 1.91 = ![]()

我们将更改数据集。![]()

0.69 -1.31 0.39 0.09 1.29 0.49 0.19 -0.81 -0.31 -0.71 ![]()

0.49 -1.21 0.99 0.29 1.09 0.79 -0.31 -0.81 -0.31 -1.01

步骤 2:找到特征值和特征向量

相关矩阵 c =

其中,X 是数据集矩阵(在这个数字中,它是一个 10 X 2 矩阵)

![]() 是 X 的转置(在这个数值中,它是一个 2 X 10 矩阵),N 是元素数 = 10

是 X 的转置(在这个数值中,它是一个 2 X 10 矩阵),N 是元素数 = 10

所以,

{所以为了计算相关矩阵,我们必须将数据集矩阵与其转置相乘}

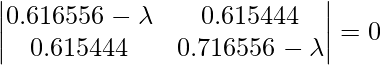

使用等式, | C - ![]() 我| = 0 –方程 (i)其中 { \lambda 是特征值,I 是单位矩阵 }

我| = 0 –方程 (i)其中 { \lambda 是特征值,I 是单位矩阵 }

所以求解方程(i)

取左边的行列式,我们得到

![]()

![]()

我们得到两个值![]() , 即(

, 即( ) = 1.28403 和 (

![]() ) = 0.0490834 。现在我们必须找到特征值的特征向量

) = 0.0490834 。现在我们必须找到特征值的特征向量和

![]()

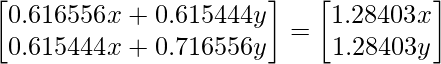

为了从特征值中找到特征向量,我们将使用以下方法:

首先,我们将使用等式找到特征值 1.28403 的特征向量 ![]()

求解矩阵,我们得到

0.616556x + 0.615444y = 1.28403x; x = 0.922049 y

(x 和 y 属于矩阵 X)所以如果我们让 y = 1,那么 x 就是 0.922049。所以现在更新后的 X 矩阵将如下所示:

IMP: Till now we haven’t reached to the eigenvectors, we have to a bit of modifications in the X matrix. They are as follows:

A. Find the square root of the sum of the squares of the element in X matrix i.e.

B. Now divide the elements of the X matrix by the number 1.3602 (just found that)

So now we found the eigenvectors for the eigenvector ![]() , they are 0.67787 and 0.73518

, they are 0.67787 and 0.73518

其次,我们将使用等式找到特征值 0.0490834 的特征向量{与上一步相同的方法)

求解矩阵,我们得到

0.616556x + 0.615444y = 0.0490834x; y = -0.922053

(x 和 y 属于矩阵 X)所以如果我们让 x = 1,y 的结果是 -0.922053 所以现在更新后的 X 矩阵将如下所示:

IMP: Till now we haven’t reached to the eigenvectors, we have to a bit of modifications in the X matrix. They are as follows:

A. Find the square root of the sum of the squares of the elements in X matrix i.e.

![]()

B. Now divide the elements of the X matrix by the number 1.3602 (just found that)

So now we found the eigenvectors for the eigenvector \lambda_2, they are 0.735176 and 0.677873

特征值之和 ( ) 和 (

![]() ) = 1.28403 + 0.0490834 = 1.33 = 总方差 {大部分方差来自

) = 1.28403 + 0.0490834 = 1.33 = 总方差 {大部分方差来自 }

第 3 步:排列特征值

具有最高特征值的特征向量是主成分 的数据集。所以在这种情况下, lambda1 的特征向量是主成分。

{基本上为了完成数值,我们只需要解决到这一步,但是如果我们必须证明为什么我们选择了那个特定的特征向量,我们必须遵循从 4 到 6 的步骤}

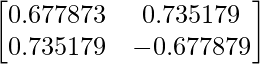

第 4 步:形成特征向量

这是数值的特征向量

这是数值的特征向量

其中第一列是特征向量 &第二列是特征向量

![]()

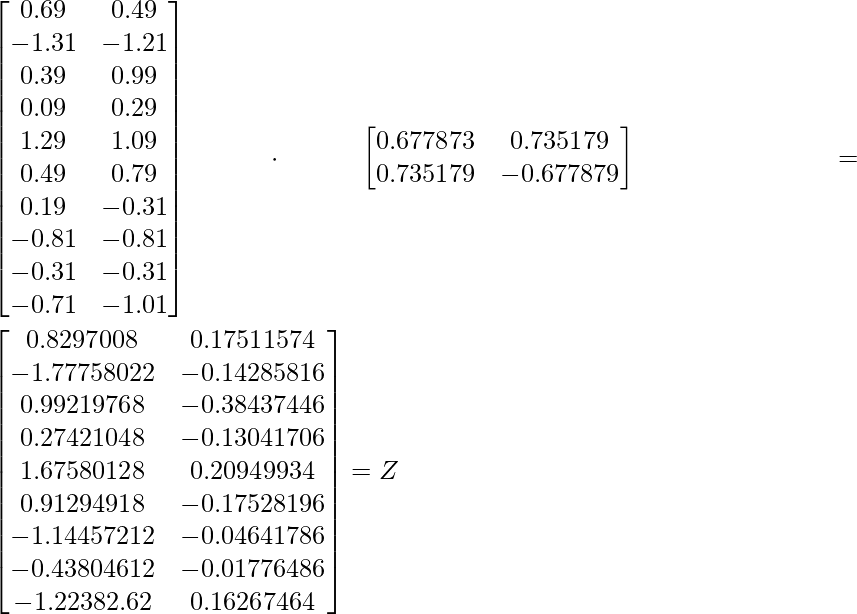

第 5 步:转换原始数据集

使用等式 Z = XV

第 6 步:重建数据

使用等式 X = ![]() (

( ![]() 是 V) 的转置,X = 行零均值数据

是 V) 的转置,X = 行零均值数据

所以为了重建原始数据,我们遵循:

行原始数据集 = 行零均值数据 + 原始均值

所以对于第一特征值的特征向量,可以像原始数据集一样重构数据。因此我们可以说数据集的主成分是 ![]() 是 1.28403 然后是

是 1.28403 然后是 ![]() 即 0.0490834

即 0.0490834