广义线性模型

先决条件:

- 线性回归

- 逻辑回归

以下文章讨论了广义线性模型(GLM),它解释了线性回归和逻辑回归如何成为更广泛的模型类别的成员。 GLM 可用于通过使用最能描述数据或给定用于训练模型的标签的分布类型来构建回归和分类问题的模型。下面给出了一些类型的数据集和相应的分布,它们将帮助我们为特定类型的数据构建模型(这里指定的术语数据是指输出数据或数据集的标签)。

- 二元分类数据——伯努利分布

- 实值数据 - 高斯分布

- 计数数据 – 泊松分布

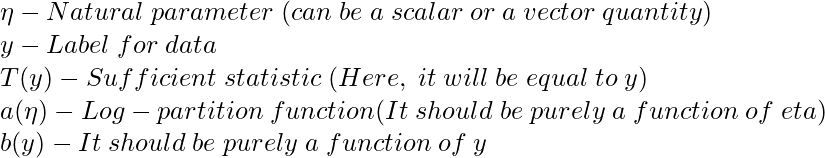

为了理解 GLM,我们将从定义指数族开始。指数族是一类分布,其概率密度函数(PDF) 可以塑造为以下形式:

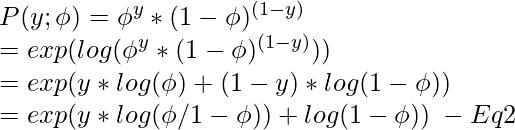

证明——伯努利分布是指数族的一成员。

因此,比较EQ1和EQ2:

Note: As mentioned above the value of phi (which is the same as the activation or sigmoid function for Logistic regression) is not a coincidence. And it will be proved later in the article how Logistic regression model can be derived from the Bernoulli distribution.

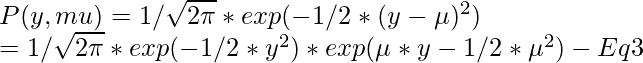

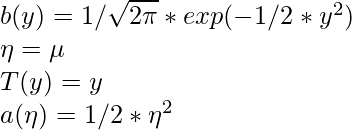

证明——高斯分布是指数族的一成员。

因此,在比较Eq1和Eq3 时:

构建 GLM:

要为特定类型的数据或更一般地为线性或逻辑分类问题构建 GLM,需要考虑以下三个假设或设计选择:

![由 QuickLaTeX.com 渲染 y|x;\theta \sim exponential\hspace{1mm} family(\eta)\\ Given \hspace{1mm}x\hspace{1mm} our\hspace{1mm} goal\hspace{1mm} is\hspace{1mm} to\hspace{1mm} predict \hspace{1mm}T(y)\hspace{1mm} which \hspace{1mm}is \hspace{1mm}equal \hspace{1mm}to\hspace{1mm} y \hspace{1mm}in\hspace{1mm} our\hspace{1mm} case \hspace{1mm}or \hspace{1mm}h(x) = E[y|x] = \mu\\ \eta = \theta^T * x](https://mangodoc.oss-cn-beijing.aliyuncs.com/geek8geeks/Generalized_Linear_Models_8.jpg)

第一个假设是,如果x是由THETA参数所产生的输出的输入数据或y将是指数家族的一个成员。这意味着如果我们提供了一些标记数据,我们的目标是找到尽可能接近给定模型的正确参数 theta。第三个假设是最不合理的,可以被视为一种设计选择。

线性回归模型:

为了证明线性回归是 GLM 的一个特例。认为输出标签是连续值,因此是高斯分布。所以,我们有

![由 QuickLaTeX.com 渲染 y|x;\theta \sim \mathcal{N}(\mu, \sigma^2) \\ h_\theta(x) = E[y|x;\theta]\\ \hspace{0.9cm} = \mu\\ \hspace{0.9cm} = \eta\\ \hspace{0.9cm} = \theta^Tx](https://mangodoc.oss-cn-beijing.aliyuncs.com/geek8geeks/Generalized_Linear_Models_9.jpg)

上面的第一个方程对应于第一个假设,即输出标签(或目标变量)应该是指数族的成员,第二个方程对应于假设等于分布的期望值或均值的假设,最后,第三个方程对应于自然参数和输入参数遵循线性关系的假设。

逻辑回归模型:

证明逻辑回归是 GLM 的一个特例。输出标签被认为是二进制值,因此是伯努利分布。所以,我们有

![由 QuickLaTeX.com 渲染 y|x;\theta \sim Bernoulli(\phi) \\ h_\theta(x) = E[y|x;\theta]\\ \hspace{0.9cm} = \mu\\ \hspace{0.9cm} = 1/1+e^{-\eta}\\](https://mangodoc.oss-cn-beijing.aliyuncs.com/geek8geeks/Generalized_Linear_Models_10.jpg)

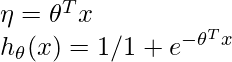

从第三个假设可以证明:

映射到标准参数的自然参数的函数被称为规范应答函数(这里,日志分区函数)和逆的,它被称为规范链接函数。

因此,通过使用前面提到的三个假设,可以证明Logistic和线性回归属于一个更大的模型家族,称为 GLM。

参考: http : //cs229.stanford.edu/notes/cs229-notes1.pdf